-

Hive- Hive安装

Hive安装 1.1下载Hive安装包 官网:http://hive.apache.org/downloads.html 个人建议到这里下载:http://apache.forsale.plus/ 1.2将hive文件上传到HADOOP集群,并解压 将文件上传到 /usr ,解压 tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /usr/ 重命名:…- 0

- 0

- 83

-

Python- and & or 的短路原则

条件1 and 条件2 条件1 or 条件2 短路原则 对于and 如果前面的第一个条件为假,那么这个and前后两个条件组成的表达式的计算结果就一定为假,第二个条件就不会被计算 对于or 如果前面的第一个条件为真,那么这个or前后两个条件组成的表达式的计算结果就一定为真,第二个条件就不会被计算- 0

- 0

- 95

-

CDH- cdh kafka已经卸载了,但是服务器还有kafka-topics这些命令可用,导致重新安装kafka出现问题

CDH- cdh kafka已经卸载了,但是服务器还有kafka-topics这些命令可用,导致重新安装kafka出现问题 cdh界面删除并不会将 kafka数据删除,需要将kafka集群节点 var/local/kafka/data 清理掉 然后将zk brokers/topics 下的topic也清理掉- 0

- 0

- 59

-

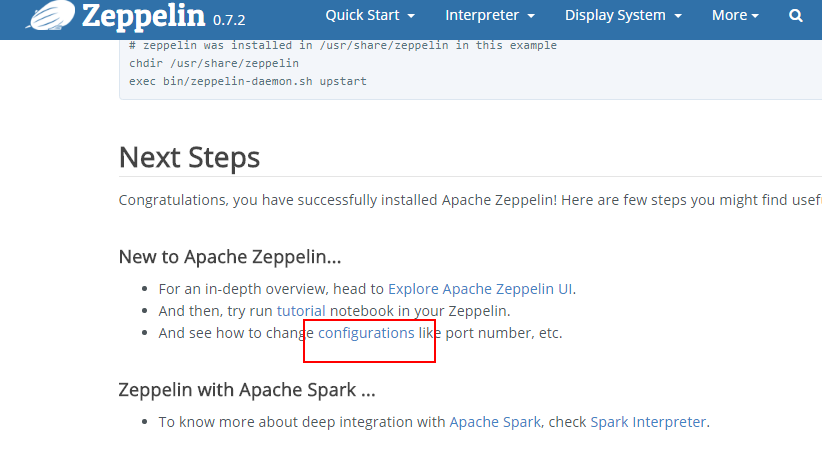

Zeppelin- Linux下安装Zeppelin

前期部署: 下载,解压,配置PATH环境(编辑/etc/profile文件,记得source一下该文件) zepplin配置参考文档:https://zeppelin.apache.org/docs/0.7.2/install/configuration.html 往conf/zeppelin-env.sh文件中添加端口号 往底部添加 export ZEPPLELIN_PORT=8090 修改配置…- 0

- 0

- 106

-

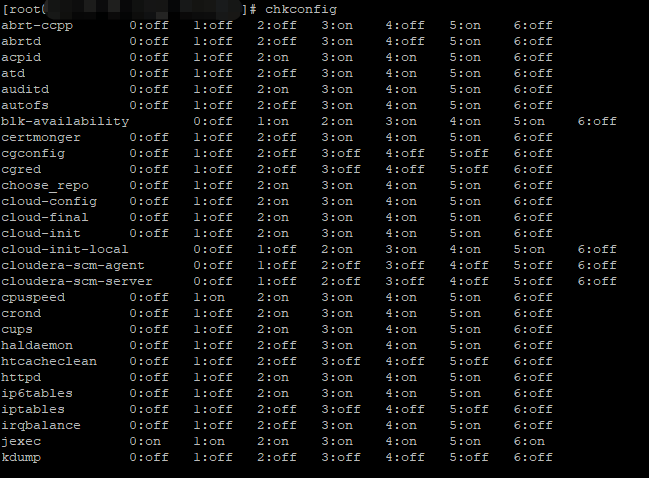

Linux- AWS之EC2大数据集群定时开关机

众所周知,云计算就是在计算你的钱,每当ec2开起来就要开始计费。当用户购买了一个庞大的与服务器做一个集群,尤其是用来做大数据集群,这些服务器的配置相当高,每台服务器所需要的费用不菲。其实在很多时候没能够完全利用起其全部的资源,尤其在空闲时间,在夜间没有作业的情况下,这些服务器完全处于空闲的状态,却时刻在计费,这是相当不划算的。于是有这样一个方案,我们是不是可以在机器处于空闲的状态时将…- 0

- 0

- 127

-

Scala- Double类型工具类

格式化分数,按照指定小数位四舍五入工具类 package com.rz.util object NumberUtils { /** * 格式化小数 * @param num Double对象 * @param scale 四舍五入的位数 * @return 格式化后的小数 */ def formatDouble(num: Double, scale: Int)={ val decim…- 0

- 0

- 69

-

Spark- Spark内核架构原理和Spark架构深度剖析

Spark内核架构原理 1.Driver 选spark节点之一,提交我们编写的spark程序,开启一个Driver进程,执行我们的Application应用程序,也就是我们自己编写的代码。Driver会根据我们对RDD定义的操作,提交一大堆的task去Executor上。Driver注册了一些Executor之后,就可以开始正式执行我们的Spark应用程序了,首先第一步,创建初始RD…- 0

- 0

- 73

-

Storm- 使用Storm实现词频汇总

需求:读取指定目录的数据,并实现单词计数的功能 实现方案: Spout来读取指定目录的数据,作为后续Bolt处理的input 使用一个Bolt把input 的数据,切割分开,我们按照逗号进分割 使用一个Bolt来进行最终的单词次数统计操作并输出 拓扑设计:DataSourceSpout ==>SpiltBolt ==>CountBolt Storm编程注意,…- 0

- 0

- 86

-

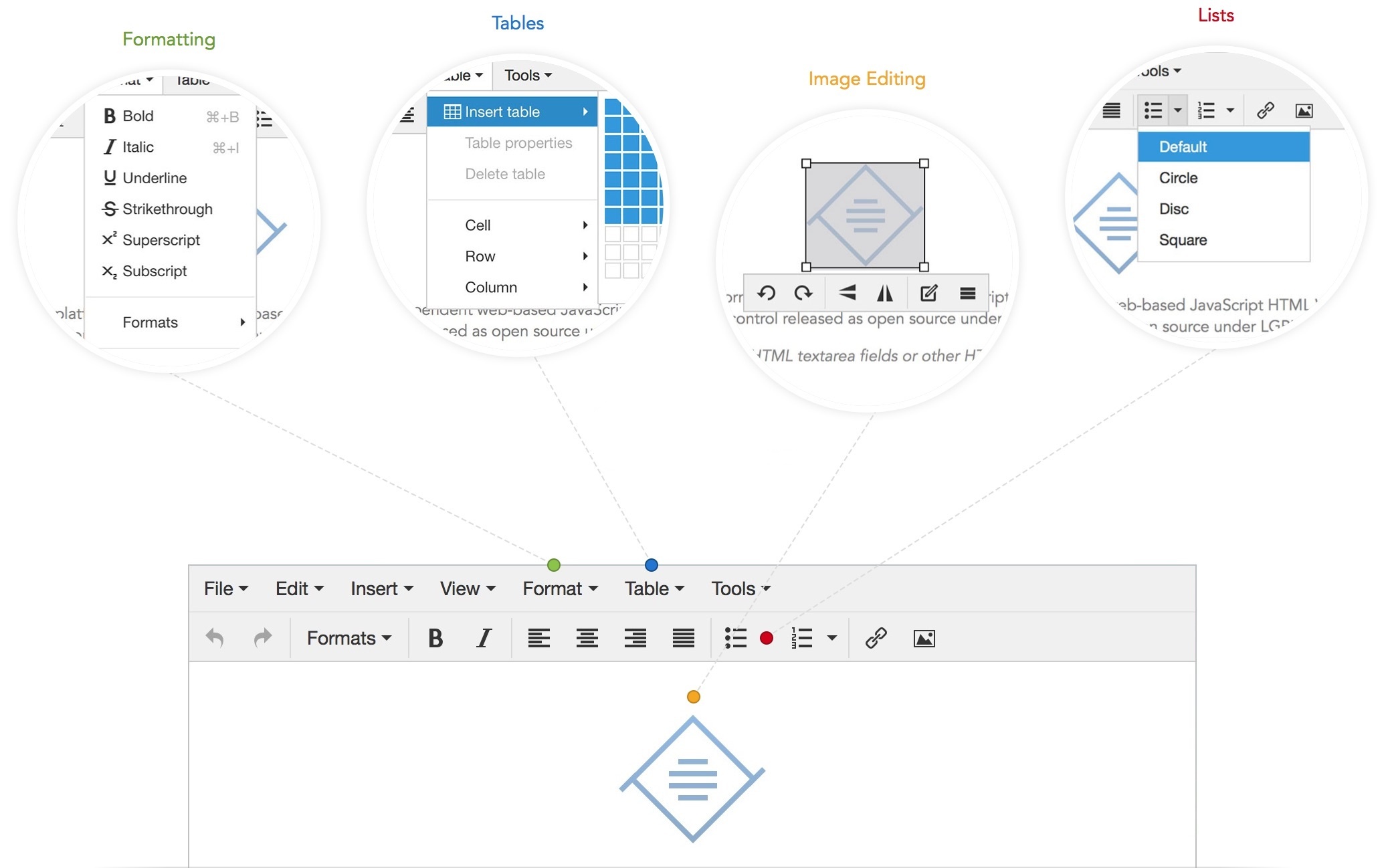

TinyMCE v4.5.0 可视化HTML编辑器

资源简介:TinyMCE是一个轻量级的基于浏览器的所见即所得编辑器,支持目前流行的各种浏览器,采用JavaScript/ECMAScript开发,主要特性包括主题/模板支持,多语言支持(包括简体中文),支持通过插件的方式进行扩展。功能配置灵活简单(两行代码就可以将编辑器嵌入网页中),支持AJAX。另一特点是加载速度非常快,如果你的服务器采用的脚本语言是 PHP,那还可以进一步优化。最重要的是,Ti…- 0

- 0

- 211

-

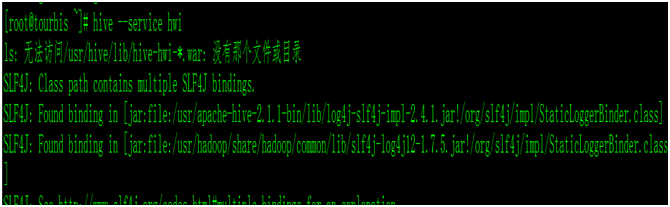

Hive- Hive Web Interface

当我们安装好hive时候,我们启动hive的UI界面的时候,命令: hive –-service hwi ,报错,没有war包 我们查看hive/conf/hive-default.xml.template,查找hwi 把这3台属性复制,添加到hive-site.xml里面, vim hive-site.xml <property> <name>hive.hw…- 0

- 0

- 118

-

Storm- Storm作业提交运行流程

用户编写Storm Topology 使用client提交Topology给Nimbus Nimbus指派Task给Supervisor Supervisor为Task启动Worker Worker执行Task- 0

- 0

- 79

-

SpringBoot- springboot集成Redis出现报错:No qualifying bean of type ‘org.springframework.data.redis.connection.RedisConnectionFactory’

Springboot将accessToke写入Redisk 缓存,springboot集成Redis出现报错 No qualifying bean of type 'org.springframework.data.redis.connection.RedisConnectionFactory' 原因:我们在pom.xml中引入了spring-boo…- 0

- 0

- 417

-

Spark- Spark Yarn模式下跑yarn-client无法初始化SparkConext,Over usage of virtual memory

在spark yarn模式下跑yarn-client时出现无法初始化SparkContext错误. 17/09/27 16:17:54 INFO mapreduce.Job: Task Id : attempt_1428293579539_0001_m_000003_0, Status : FAILED Container [pid=7847,containerID=containe…- 0

- 0

- 85

-

HIVE- 大数据运维之hive管理

我现在在一家公司负责大数据平台(CDH平台)的运维管理,最常遇见的问题我总结出来,并且继续在下面更新。希望方便自己以后trouble shooting以及方便各位同行解决问题与学习。 关于做运维有几个重要的要点一定一定要遵守的: 遇到问题冷静,冷静,冷静,就山崩都要冷静,心态关乎你是否能将问题解决同时不会给人留下不好的印象。 凡是关于对集群更改与变动的操作,一定要在测试环境测试到没问…- 0

- 0

- 107

-

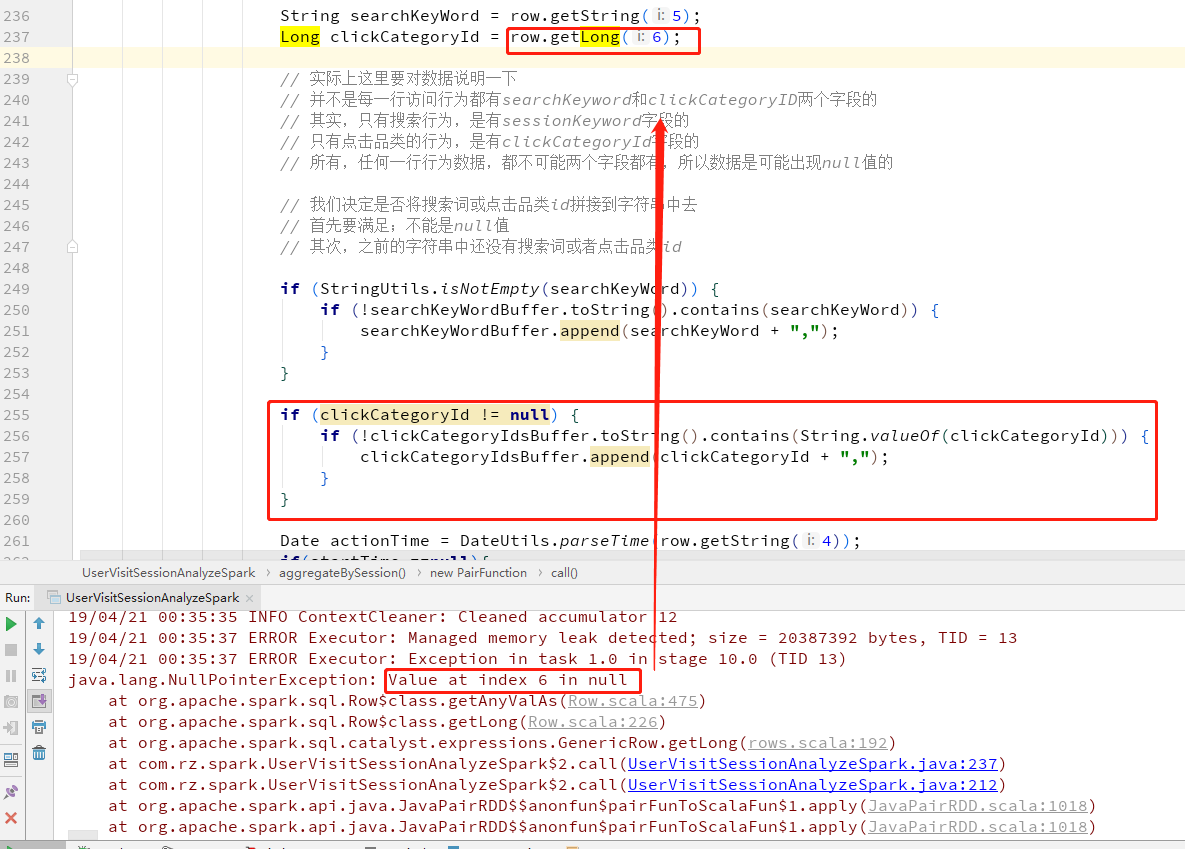

Spark- SparkSQL中 Row.getLong 出现NullPointerException错误的处理方法

在SparkSQL中获取Row的值,而且Row的字段允许null时,在取值的时候取到null赋值给新的变量名会报NullPointerException错误, 可以先用row.isNullAt(index)去判断该字段的值是否为空 首先上错误 修改为先初始化变量,判断row.isNullAt(6) 如果不为空就将值赋值给变量- 0

- 0

- 117

-

Spark- Spark普通Shuffle操作的原理剖析

在spark中,什么情况下会发生shuffle? reduceByKey,groupByKey,sortByKey,countByKey,join,cogroup等操作。 默认的shuffle操作的原理剖析 假设有一个节点上面运行了4个 ShuffleMapTask,然后这个节点上只有2个 cpu core。假如有另外一台节点,上面也运行了4个ResultTask,现在呢,正等着要去…- 0

- 0

- 58

-

Architect v2.0.6_HTML网站在线生成器

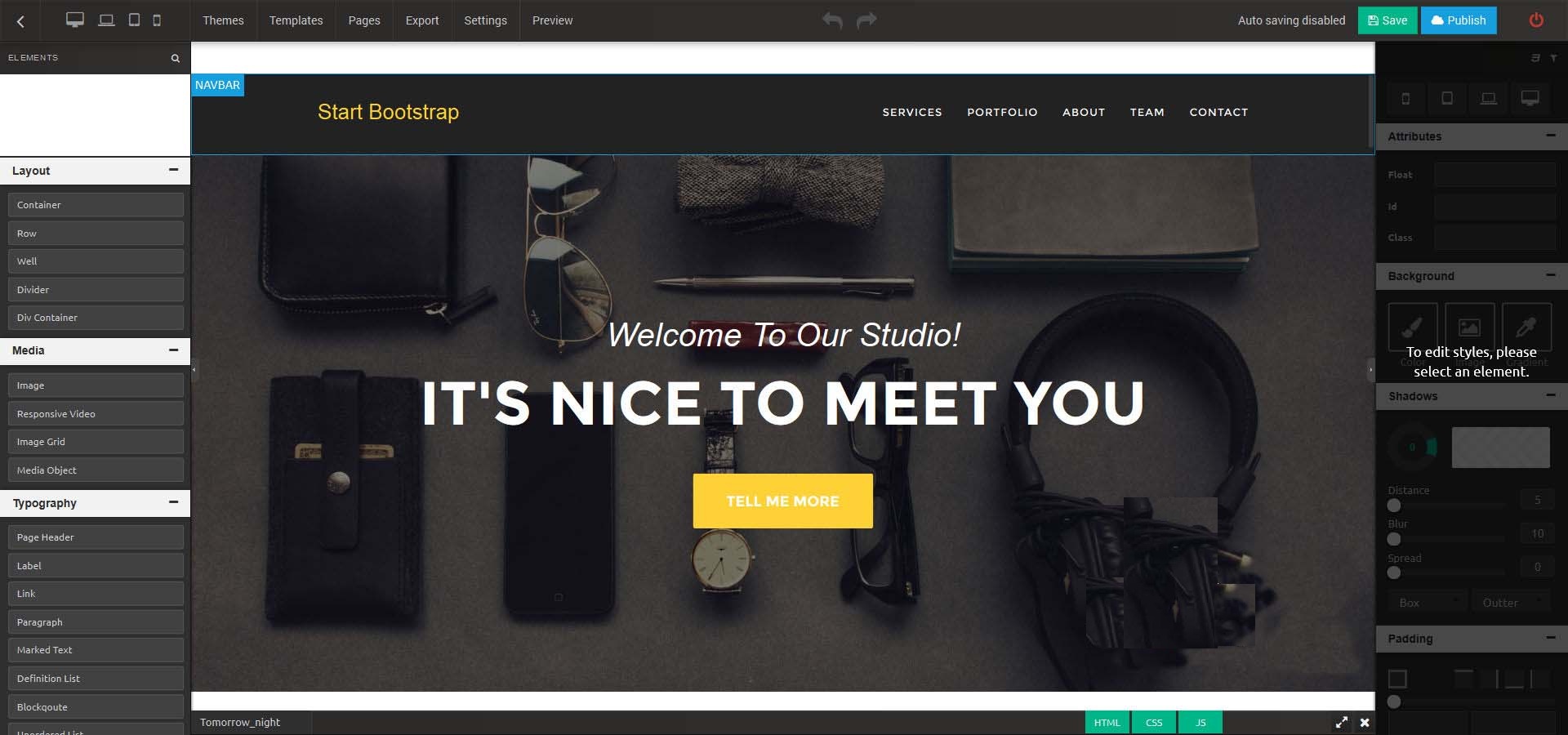

资源简介:Architect是功能强大且易于使用的HTML静态网站在线生成器,它除了具有HTML静态网站在线生成的功能,同时还提供独特的功能,如主题和模板的选择,干净整洁的代码,最佳的可视化CSS和图像编辑器 以及更多更多的功能。Architect 网站在线生成器功能特性易于安装、订阅/账单、外观编辑、文本编辑器、高级拖放功能、完整的文档、上下文菜单、可翻译、多种元素、在线CSS编辑器、发布或导出…- 0

- 0

- 154

-

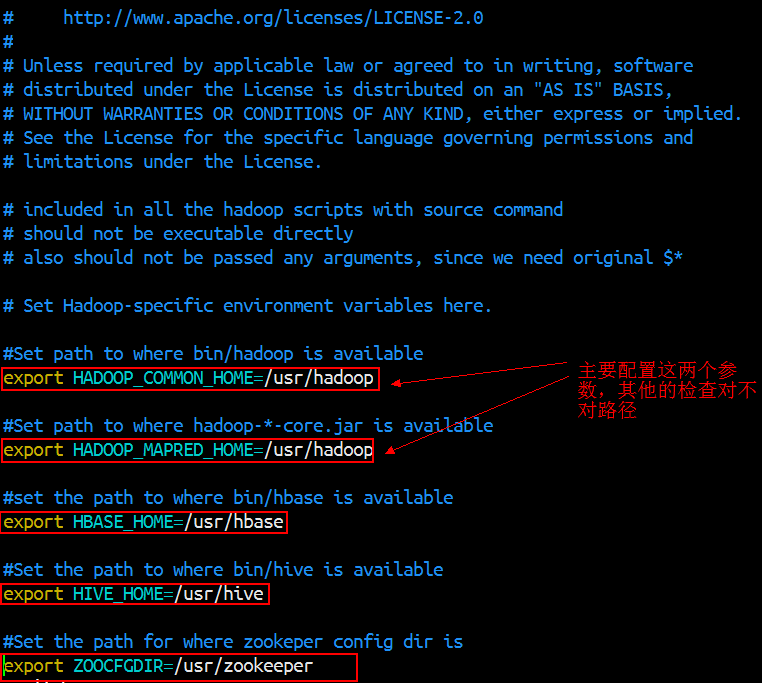

Sqooop- 使用Sqoop进行数据的导入导出

Sqoop是Apache旗下的一个开源框架,专门用来做数据的导入和导出。 官网:https://sqoop.apache.org/ Sqoop的安装非常简单,只需要把下载下来的tar包解压设置两个环境变量就可以了 1.安装部署 下载版本:sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz 官网:http://mirror.bit.edu.cn/apa…- 0

- 0

- 162

-

Kafka- Kafka架构功能

Kafka是一个高吞吐量的分布式消息系统,一个分布式的发布-订阅消息系统。Kafka是一种快速,可拓展的,设计内在就是分布式的,分区的可复制的提交日志服务。 Apache Kafka与传统消息系统相比,有以下不同: 它设计为一个分布式系统,易于向外拓展; 它同时为发布和订阅提供高吞吐量; 它支持多订阅者,当失败时能自动平衡消费者; 它将消息持久化到磁盘,因此可用于批量消费,例如ETL…- 0

- 0

- 53

-

数据仓库- 建模理念

数仓建模的目标 访问性能:能够快速查询所需的数据,减少数据I/O 数据成本:减少不必要的数据冗余,实现计算结果数据复用,降低大数据系统中的存储成本和计算成本。 使用效率:改善用户使用体验,提高使用数据的效率 数据质量:改善数据统计口径的不一致性,减少数据计算错误的可性,提供高质量的、一致的数据访问平台 大数据的数仓建模需要通过建模的方法更好的组织、存储数据、以便在性能、…- 0

- 0

- 67

-

Hadoop- Hadoop详解

首先所有知识以官网为准,所有的内容在官网上都有展示,所有的变动与改进,新增内容都以官网为准。hadoop.apache.org Hadoop是一个开源的可拓展的分布式并行处理计算平台,利用服务器集群根据用户的自定义业务逻辑,对海量数据进行分布式处理。Hadoop提供了一个可靠的共享存储和分析系统,Hadoop的核心三大组件有HDFS(分布式文件系统),MapReduce(分布式运算编程框架),YA…- 0

- 0

- 168

-

Spark- 求最受欢迎的TopN课程

数据库操作工具类 package com.rz.mobile_tag.utils import java.sql.{Connection, DriverManager, PreparedStatement} object MySQLUtils { /** * 获取数据库连接 * @return */ def getConnection()={ DriverManager.getCon…- 0

- 0

- 147

-

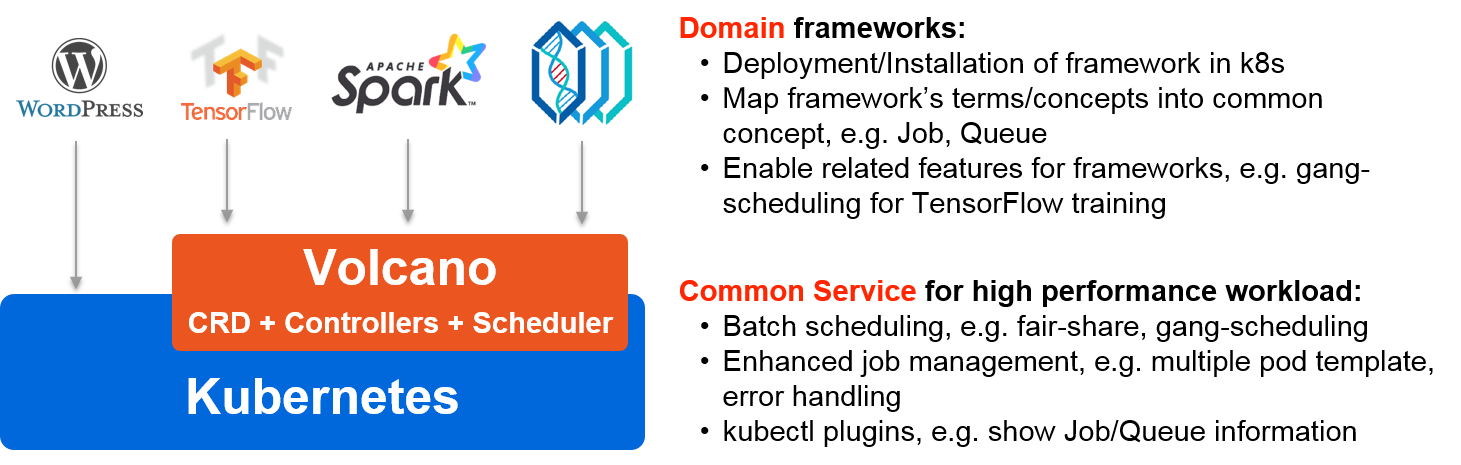

华为发布 Volcano 开源项目,方便 AI、大数据、基因、渲染等诸多行业通用计算框架接入

Volcano 是基于 Kubernetes 的批处理系统,源自于华为云 AI 容器。Volcano 方便 AI、大数据、基因、渲染等诸多行业通用计算框架接入,提供高性能任务调度引擎,高性能异构芯片管理,高性能任务运行管理等能力。 授权协议: Apache 开发语言: Google Go 操作系统: Linux 开发厂商: 华为 整体架构 Volcano 提供一整套目前 K8S 在批量和弹性工作负…- 0

- 0

- 251

-

Spark- 优化后的 shuffle 操作原理剖析

在spark新版本中,引入了 consolidation 机制,也就是说提出了ShuffleGroup的概念。一个 ShuffleMapTask 将数据写入 ResultTask 数量的本地文本,这个不会变。但是,当下一个 ShuffleMapTask 运行的时候,可以直接将数据写入之前的 ShuffleMapTask 的本地文件。相当于是,对多个 ShuffleMapTask 输出…- 0

- 0

- 54

-

Spark-Spark setMaster & WordCount Demo

Spark setMaster源码 /** * The master URL to connect to, such as "local" to run locally with one thread, "local[4]" to * run locally with 4 cores, or "spark://master:7077&…- 0

- 0

- 148

-

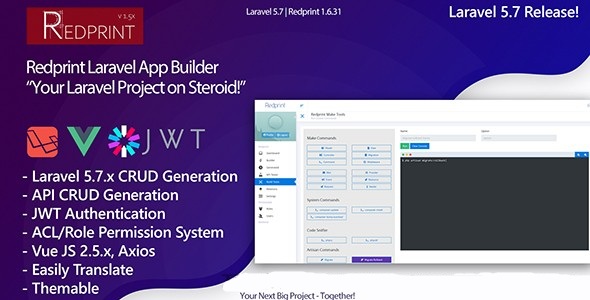

可视化开发laravel应用 Redprint Laravel App Builder CRUD Generator Plus v1.6.32 有安装指导

资源简介:Redprint App Builder is your app development flow on steroid! It’s your perfect Laravel CRUD Booster and App Builder. It has everything from it’s own Terminal Emulator, A Very powerful File Brows…- 0

- 0

- 137

-

Hadoop- NameNode和Secondary NameNode元数据管理机制

元数据的存储机制A、内存中有一份完整的元数据(内存meta data)B、磁盘有一个“准完整”的元数据镜像(fsimage)文件(在namenode的工作目录中)C、用于衔接内存metadata和持久化元数据镜像fsimage之间的操作日志(edits文件)NameNode和Secondary NameNode元数据管理机制客户端每次对文件的操作,如果涉及到元数据的更新(读除外),比如…- 0

- 0

- 75

-

Spark- RDD简介

Spark里面提供了一个比较重要的抽象——弹性分布式数据集(resilient distributed dataset),简称RDD。弹性:数据可大可小,可分布在内存或磁盘,当某台机器宕机时,能够按照RDD的liveage重新计算,从而恢复。 RDD有5个特性: 1.一个分区列表,用于并行计算,每个分区对应一个原子数据集,作为这个分区的数据输入 2.计算这个RDD某个分区数据(这个分…- 0

- 0

- 77

-

Python- NumPy

NumPy包括的内容 NumPy系统是 Python的一种开源的数值计算扩展,是一个用 python实现的科学计算包。包括: 一个具有矢量算术运算和复杂广播能力的快速且节省空间的多维数组,称为 ndarray(N-dimensional array object ) 用于对整组数据进行快速运算的标准数学函数, func( universal function object) 用于整…- 0

- 0

- 187

-

Hadoop- 分布式资源管理YARN架构讲解

YARN是分布式资源管理,每一台机器都要去管理该台计算机的资源,Yarn负责为MapReduce程序分配运算硬件资源。每一台机器的管理者叫 NodeManager,整个集群的管理者管理着整个集群的NodeManager,叫 ResourceManager。资源调度和资源隔离是YARN作为一个资源管理系统最重要和最基础的两个功能。资源调度由 ResourceManager 完成,而资源…- 0

- 0

- 99

-

Kafka- Spark消费Kafka

在高版本的API中 val brokers = properties.getProperty("kafka.host.list") val topics = Set(properties.getProperty("kafka.application.topic")) val kafkaParams = Map[String, String]( …- 0

- 0

- 95

-

Spark- 数据清洗

输入输出转化工具类 package com.rz.mobile_tag.log import org.apache.spark.sql.Row import org.apache.spark.sql.types.{LongType, StringType, StructField, StructType} /** * 访问日志转换(输入==>输出)工具类 */ object A…- 0

- 0

- 109

-

Apache Kudu 1.10.0 发布,Hadoop 生态数据存储系统

Apache Kudu 1.10.0 发布了,Kudu 是一个支持结构化数据的开源存储引擎,具有低延迟随机读取与高效分析读取模式。它基于 Apache Hadoop 生态系设计,并支持与 Apache 软件基金会其它数据分析项目集成。 此版本带来的新特性包括: Kudu 现在通过使用 Apache Spark 实现的作业支持完整和增量表备份。此外,它还支持通过使用 Apache Spark 实现的…- 0

- 0

- 132

-

Spark- Checkpoint原理剖析

Checkpoint,是Spark 提供的一个比较高级的功能。有的时候,比如说,我们的 Spark 应用程序,特别的复杂,然后从初始的RDD开始,到最后拯个应用程序完成,有非常多的步骤,比如超过20个transformation 操作。而且整个应用运行的时间也特别的长,比如通常要运行1-5小时。 在上述的情况下,就比较适合使用checkpoint 功能。因为,对于特别复杂的 Spar…- 0

- 0

- 93