-

JAVA-关键字&标识符

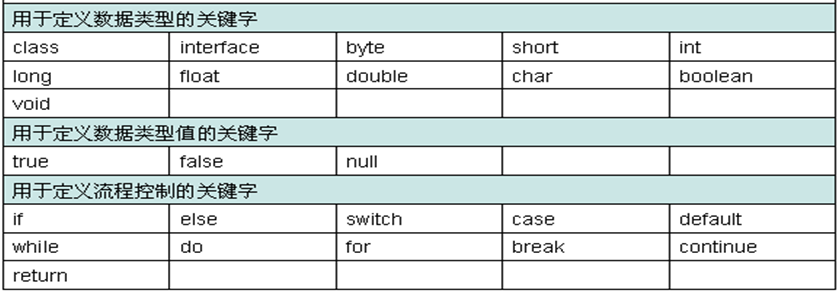

关键字: 关键字就是在java程序中具备特殊含义的标识符。关键字一般用于描述一个程序的结构或者表示数据类型。他们用来表示一种数据类型,或者表示程序的结构等,关键字不能用作变量名、方法名、类名、包名。 1.1 常见的关键字 备注:不必死记硬背,如果使用关键字作为标识符,编译器能提示错误。 goto 是java的保留关键字,意思是java并没有使用goto,以后是否使用未定。 &nb…...

- 0

- 0

- 61

-

Spark- 使用第三方依赖解析IP地址

使用 github上已有的开源项目 1)git clone https://github.com/wzhe06/ipdatabase.git 2)编译下载的项目: mvn clean package- DskipTests 3)安装jar包到自己的 maven仓库 mvn install: install-file -Dfile=${编译的jar包路径}/target/ipdatab…...

- 0

- 0

- 119

-

Spark- 根据ip地址计算归属地

主要考察的是广播变量的使用: 1、将要广播的数据 IP 规则数据存放在HDFS上,(广播出去的内容一旦广播出去产就不能改变了,如果需要实时改变的规则,可以将规则放到Redis中) 2、在Spark中转成RDD,然后收集到Driver端, 3、把 IP 规则数据广播到Executor中。Driver端广播变量的引用是怎样跑到 Executor中的呢? Task在Driver端生成的,…...

- 0

- 0

- 156

-

JAVA-三大语句(选择语句、条件语句、循环语句)

1 跳出指定的for循环体,和goto很像 1 2 3 4 5 6 7 8 1 K:for(int i=0;i<3;i++){//给这个for循环体取一个名字为K 2 for(int j=0;j<3;j++){ 3 if(j==1){break K;}//如果你不指跳出的for循环,那么就是跳出本地for循环,这里指定K,则调试for循环名称为K的…...

- 0

- 0

- 56

-

Spark- 自定义排序

考察spark自定义排序 方式一:自定义一个类继承Ordered和序列化,Driver端将数据变成RDD,整理数据转成自定义类类型的RDD,使用本身排序即可。 package com.rz.spark.base import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} // 自定…...

- 0

- 0

- 103

-

JAVA- continue与break与return关键字

continue与break关键字 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 for(int i=0;i<10;i++){ if(i%2==0){ continue; //跳过当前循环执行下一次循环 } System.out.println(i); } for(int…...

- 0

- 0

- 58

-

Spark- JdbcRDD以及注意事项

先上Demo package com.rz.spark.base import java.sql.DriverManager import org.apache.spark.rdd.JdbcRDD import org.apache.spark.{SparkConf, SparkContext} object JdbcRDDDemo { def main(args: Array[St…...

- 0

- 0

- 58

-

JAVA- 面向对象

程序的发展经历了两个主要阶段:面向过程、面向对象。面向对象是当前软件开发的主流。 面向过程就是分析出解决所需要的步骤,然后用函数将这些步骤一步一步实现,使用的时候一个一个一次调用。 面向对象是把构成问题的事务分解成各个对象。建立对象的目的不是为了完成一个步骤而是为了描述某个事物在整个解决问题步骤中的行为。 面向对象是为了专注在程序中采用封装、继承、多态等设计方法。面向对象的设计是一种…...

- 0

- 0

- 87

-

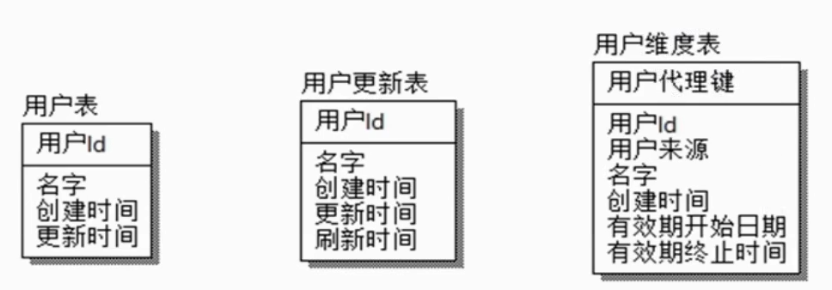

HIVE- SCD缓慢变化维

SCD缓慢变化维,比如一个用户维表,用户属性会变化,但是不会变化很剧烈,可能一年只会变化一两次,也不会所有用户的属性都会有变化,只有少量的数据发生变化,所以叫缓慢变化维。这种问题就是由于维度的变化所造成的。 解决方式: 是否保留历史数据 保留多久历史数据 历史状态如何与事实表关联 SCD1 保留最新状态 注册日期 用户编号 手机号码 2019-01-01 0001 111111 20…...

- 0

- 0

- 73

-

Scala- Double类型工具类

格式化分数,按照指定小数位四舍五入工具类 package com.rz.util object NumberUtils { /** * 格式化小数 * @param num Double对象 * @param scale 四舍五入的位数 * @return 格式化后的小数 */ def formatDouble(num: Double, scale: Int)={ val decim…...

- 0

- 0

- 70

-

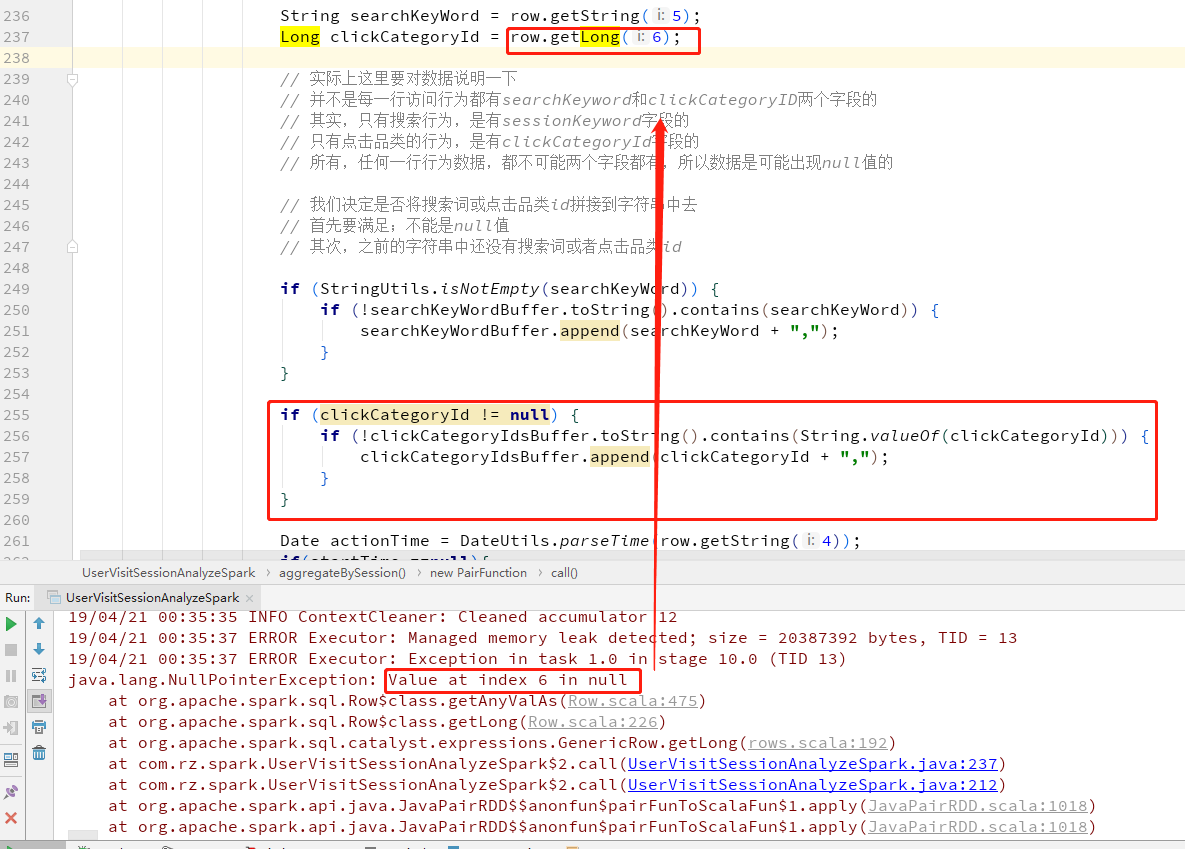

Spark- SparkSQL中 Row.getLong 出现NullPointerException错误的处理方法

在SparkSQL中获取Row的值,而且Row的字段允许null时,在取值的时候取到null赋值给新的变量名会报NullPointerException错误, 可以先用row.isNullAt(index)去判断该字段的值是否为空 首先上错误 修改为先初始化变量,判断row.isNullAt(6) 如果不为空就将值赋值给变量 ...

- 0

- 0

- 117

-

JAVA- 成员变量与局部变量的区别

成员变量与局部变量的区别 成员变量是定义在方法之外,类之内的 局部变量是定义在方法之内的。 作用上的区别: 1.成员变量的作用是用于描述一类事物的公共属性的。 2.局部变量的作用就是提供一个变量给方法内部使用而已。 生命周期的区别: 1.成员变量随着对象的创建而存在,随着对象的消失而消失。 2.局部变量在调用了对应的方法时执行到了创建该变量的语句时存在,局部变量一旦出了自己的作用域那…...

- 0

- 0

- 57

-

Spark- 求最受欢迎的TopN课程

数据库操作工具类 package com.rz.mobile_tag.utils import java.sql.{Connection, DriverManager, PreparedStatement} object MySQLUtils { /** * 获取数据库连接 * @return */ def getConnection()={ DriverManager.getCon…...

- 0

- 0

- 148

-

Spark- 数据清洗

输入输出转化工具类 package com.rz.mobile_tag.log import org.apache.spark.sql.Row import org.apache.spark.sql.types.{LongType, StringType, StructField, StructType} /** * 访问日志转换(输入==>输出)工具类 */ object A…...

- 0

- 0

- 110

-

Hadoop- HDFS的API操作

1、引入依赖 <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>2.6.1</version> </dependency> 注:如需手动引入ja…...

- 0

- 0

- 150

-

Spark- 常见问题

记录spark使用中常见问题 SparkSQL 日期解析时用到SimpleDateFormat, SimpleDateFormat是线程不安全的。可以使用 FastDateFormat 如: import org.apache.commons.lang3.time.FastDateFormat // 输入文件日期时间格式 // [10/Nov/2018:00:01:02 +0800]…...

- 0

- 0

- 87

-

spark- PySparkSQL之PySpark解析Json集合数据

PySparkSQL之PySpark解析Json集合数据 数据样本 12341234123412342|asefr-3423|[{"name":"spark","score":"65"},{"name":"airlow","score":&quo…...

- 0

- 0

- 81

-

ERROR- 开发常见error

一,数据插入MySql中出现中文乱码 解决办法有: 1。新建数据库选择 create database 'GG' CHARACTER SET 'utf8 ' COLLATE 'utf8_general_ci '; 2。建表的时候: CREATE TABLE `TableA` (`ID` varchar(40) NOT NUL…...

- 0

- 0

- 72

-

JAVA- 清除数组重复元素

清除数组重复元素并打印新数组。 1 import java.util.*; 2 public class Repeat { 3 4 public static void main(String[] args) { 5 // TODO Auto-generated method stub 6 int arr[]={10,1,2,3,2,1,10}; 7 arr=clearRepeat(…...

- 0

- 0

- 71

-

JAVA- 内部类及匿名内部类

普通类,我们平时见到的那种类,就是一个后缀为.java的文件中,直接定义的类,比如 public Cat{ private String name; private int age; } 内部类, 内部类。顾名思义,就是包含在外部类中的类,就叫内部类。内部类有两种,一种是静态内部类,一种是非静态内部类。 静态内部类和非静态内部类的区别主要如下: 1…...

- 0

- 0

- 66

-

Spark- Spark从SFTP中读取zip压缩文件数据做计算

我们遇到个特别的需求,一个数据接入的流程跑的太慢,需要升级为用大数据方式去处理,提高效率。 数据: 数据csv文件用Zip 压缩后放置在SFTP中 数据来源: SFTP 数据操作: 文件和它的压缩包一致,后缀不同。文件名中包含渠道、日期、操作标记("S"追加,"N"全量,"D"删除) 升级前的操作方式: she…...

- 0

- 0

- 129

-

JAVA- JSP中解决无法在Cookie当中保存中文字符的问题

因为cookie的值是ASCII字符,不能直接把自定义cookie的值直接赋值为中文,但是要实现这个功能,还是有方法的。 1.java中已经给我们提供了方法,此时只需要导入该包就行 <%@ page language="java" import="java.util.*,java.net.*" contentType="text…...

- 0

- 0

- 58

-

JAVA- JDBC之DBHelper

<span style="font-family: 'Microsoft YaHei'; font-size: 18px;">package com.myit.util; import java.lang.reflect.Field; import java.sql.Connection; import java.sql.Drive…...

- 0

- 0

- 57

-

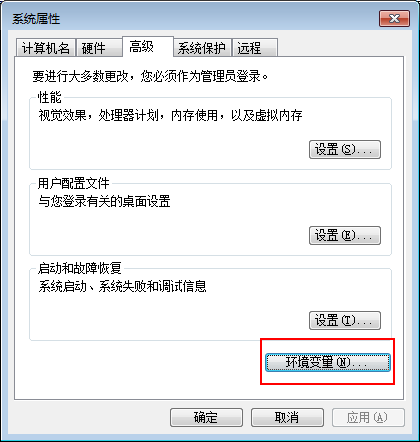

Hadoop- Hadoop环境搭建

Windows下Hadoop的安装 准备工具:64位的JDK,Hadoop安装包(我使用的是2.6.1) JDK下载地址 官网: http://www.oracle.com/technetwork/java/javase/downloads/index.html Hadoop下载地址 官网:http://hadoop.apache.org/ 1.安装JDK环境,配置系统环境变量. 选…...

- 0

- 0

- 80

-

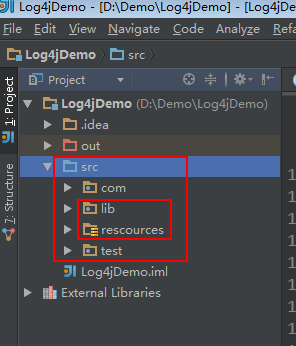

大数据- 自定义Log4j日记

1.新建一个java project,在src下新建一个lib文件夹和 rescources 文件夹,resources文件夹不能命名错误。 点击File——》project Structure...打开根据下图操作 把相关jar包放进lib文件夹里并绑定。 新建一个java文件 Log4jTest.java 和 HadoopLog4j.java 1 2 3 4 5 6…...

- 0

- 0

- 51

-

Zookeeper- Error contacting service. It is probably not running解决方案和原理

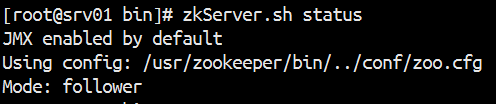

搭建启动Zookeeper集群出现Error contacting service. It is probably not running解决方案和原理 1.关闭防火墙 1 2 3 4 [root@srv01 bin]# zkServer.sh start JMX enabled by default Using config: /usr/zookeeper/bin/../con…...

- 0

- 0

- 145

-

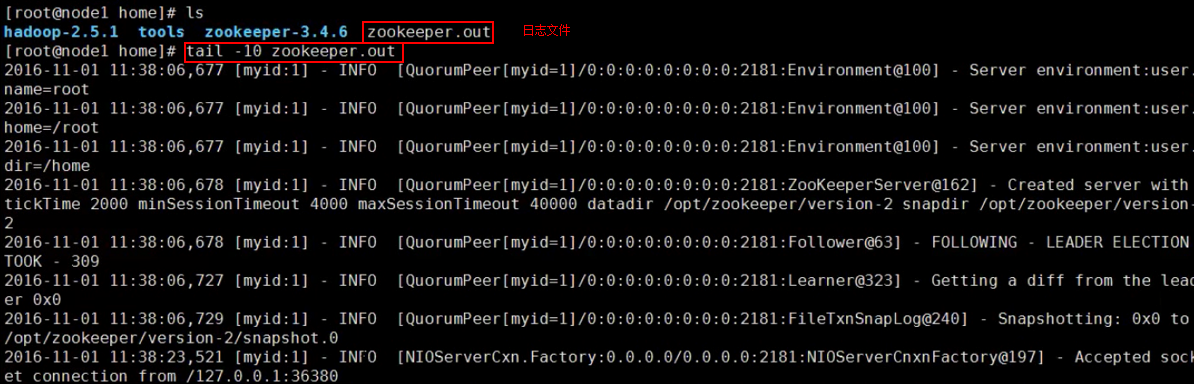

Hadoop HA- zookeeper安装配置

安装集群 1.1 虚拟机: 3台安装好JDK的centos Linux虚拟机 1.2 安装包: 把下载好的zookeeper安装包,官网:http://mirror.bit.edu.cn/apache/zookeeper/zookeeper-3.4.8/ 上传到服务器。 1.3解压 tar –xvzf zookeeper-3.4.8.tar.gz ,解压后放进 /usr/ 即可 …...

- 0

- 0

- 64

-

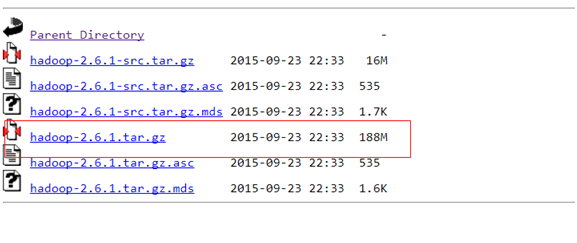

大数据之路- Hadoop环境搭建(Linux)

前期部署 1.JDK 2.上传HADOOP安装包 2.1官网:http://hadoop.apache.org/ 2.2下载hadoop-2.6.1的这个tar.gz文件,官网: https://archive.apache.org/dist/hadoop/common/hadoop-2.6.1/ 下载成功后,把这个tar.gz包上传到服务器上,命令: 通…...

- 0

- 0

- 83

-

Hadoop HA- hadoop集群部署

前期部署,至少准备3台服务器(可以是虚拟机) 1、linux系统环境准备 ip地址配置 hostname配置 hosts映射配置 关闭防火墙 service iptables stop ,也可以设置防火墙不开机自启动 chkconfig iptables off init启动级别修改 2.java环境的配置 上传jdk,解压,修改/etc/profile 3.zookeeper集群…...

- 0

- 0

- 118

-

Hive- Hive安装

Hive安装 1.1下载Hive安装包 官网:http://hive.apache.org/downloads.html 个人建议到这里下载:http://apache.forsale.plus/ 1.2将hive文件上传到HADOOP集群,并解压 将文件上传到 /usr ,解压 tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /usr/ 重命名:…...

- 0

- 0

- 83

-

Anaconda常用命令大全

1.使用conda 首先我们将要确认你已经安装好了conda 配置环境 下一步我们将通过创建几个环境来展示conda的环境管理功能。使你更加轻松的了解关于环境的一切。我们将学习如何确认你在哪个环境中,以及如何做复制一个环境作为备份。 2.测试python 然后我们将检查哪一个版本的python可以被安装,以及安装另一个版本的python,还有在两个版本的python之间的切换。 检查包 1)我们将…...

- 0

- 0

- 135

-

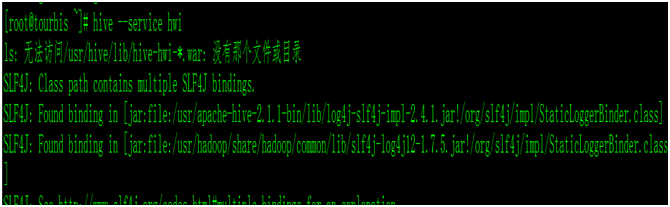

Hive- Hive Web Interface

当我们安装好hive时候,我们启动hive的UI界面的时候,命令: hive –-service hwi ,报错,没有war包 我们查看hive/conf/hive-default.xml.template,查找hwi 把这3台属性复制,添加到hive-site.xml里面, vim hive-site.xml <property> <name>hive.hw…...

- 0

- 0

- 118

-

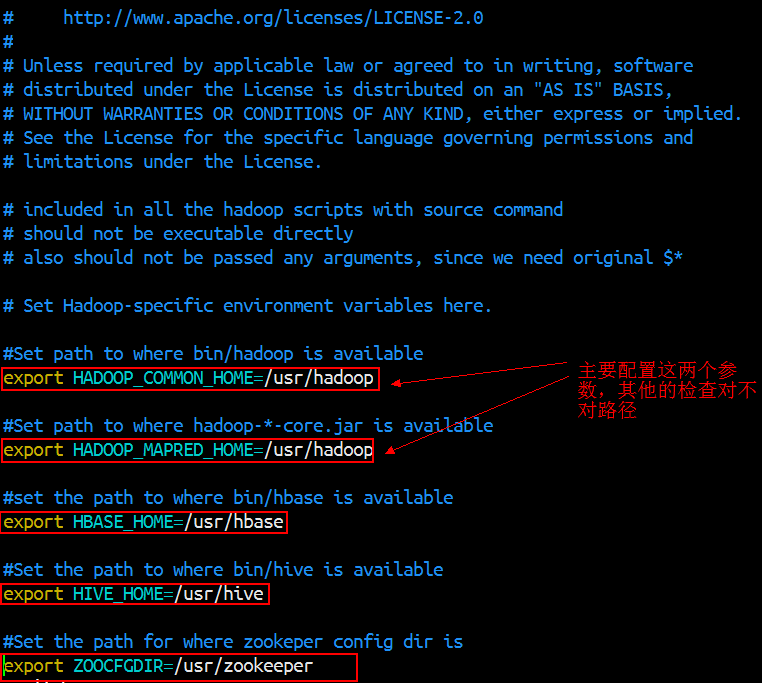

Sqooop- 使用Sqoop进行数据的导入导出

Sqoop是Apache旗下的一个开源框架,专门用来做数据的导入和导出。 官网:https://sqoop.apache.org/ Sqoop的安装非常简单,只需要把下载下来的tar包解压设置两个环境变量就可以了 1.安装部署 下载版本:sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz 官网:http://mirror.bit.edu.cn/apa…...

- 0

- 0

- 164

-

Hadoop- NameNode和Secondary NameNode元数据管理机制

元数据的存储机制A、内存中有一份完整的元数据(内存meta data)B、磁盘有一个“准完整”的元数据镜像(fsimage)文件(在namenode的工作目录中)C、用于衔接内存metadata和持久化元数据镜像fsimage之间的操作日志(edits文件)NameNode和Secondary NameNode元数据管理机制客户端每次对文件的操作,如果涉及到元数据的更新(读除外),比如…...

- 0

- 0

- 75

-

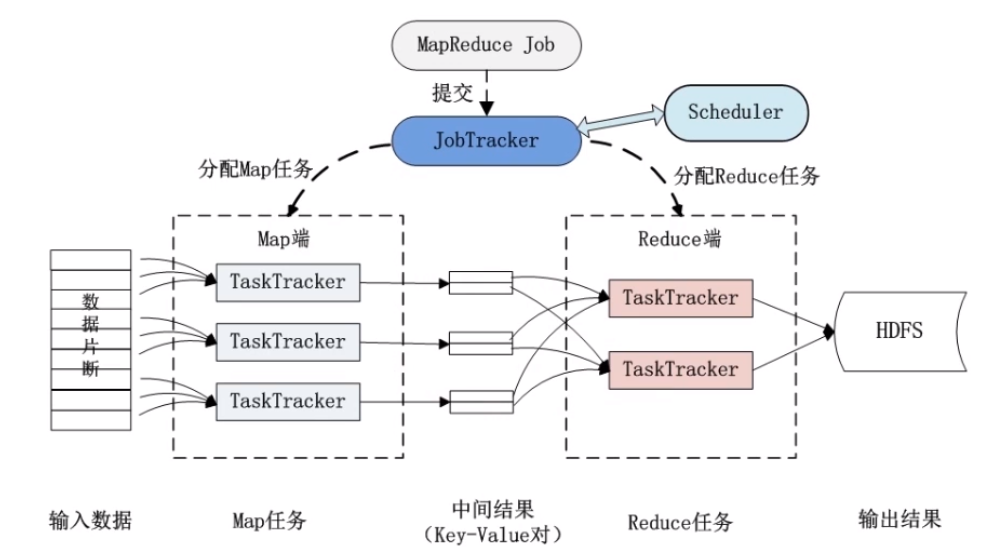

Hadoop- MapReduce分布式计算框架原理

分布式计算:原则:移动计算而尽可能减少移动数据(减少网络开销)分布式计算其实就是将单台机器上的计算拓展到多台机器上并行计算。 MapReduce是一种编程模型。Hadoop MapReduce采用Master/slave 结构。只要按照其编程规范,只需要编写少量的业务逻辑代码即可实现一个强大的海量数据并发处理程序。核心思想是:分而治之。Mapper负责分,把一个复杂的业务,任…...

- 0

- 0

- 109

-

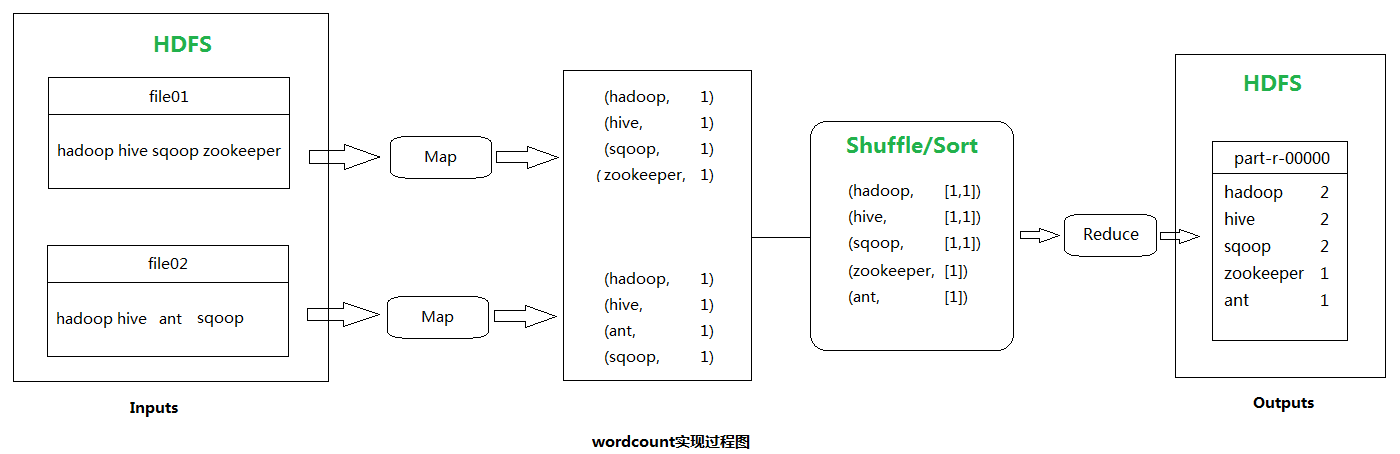

Hadoop- Wordcount程序原理及代码实现

如果对Hadoop- MapReduce分布式计算框架原理还不熟悉的可以先了解一下它,因为本文的wordcount程序实现就是MapReduce分而治之最经典的一个范例。 单词计数(wordcount)主要步骤: 1.读数据 2.按行处理 3.按空格切分行内单词 4.HashMap(单词,value+1) 等分给自己的数据片全部读取完之后 5.将HashMap按照首字母范围分为3个H…...

- 0

- 0

- 95

-

Hadoop- 流量汇总程序之如何实现hadoop的序列化接口及代码实现

流量汇总程序需求 统计每一个用户(手机号)锁耗费的总上行流量、下行流量、总流量。 流程剖析 阶段:map 读取一行数据,切分字段, 抽取手机号,上行流量,下行流量 context.write(手机号,bean) 阶段:reduce 汇总遍历每个bean,将其中的上行流量,下行流量分别累加,得到一个新的bean context.write(手机号,新bean); 代码实现…...

- 0

- 0

- 90

-

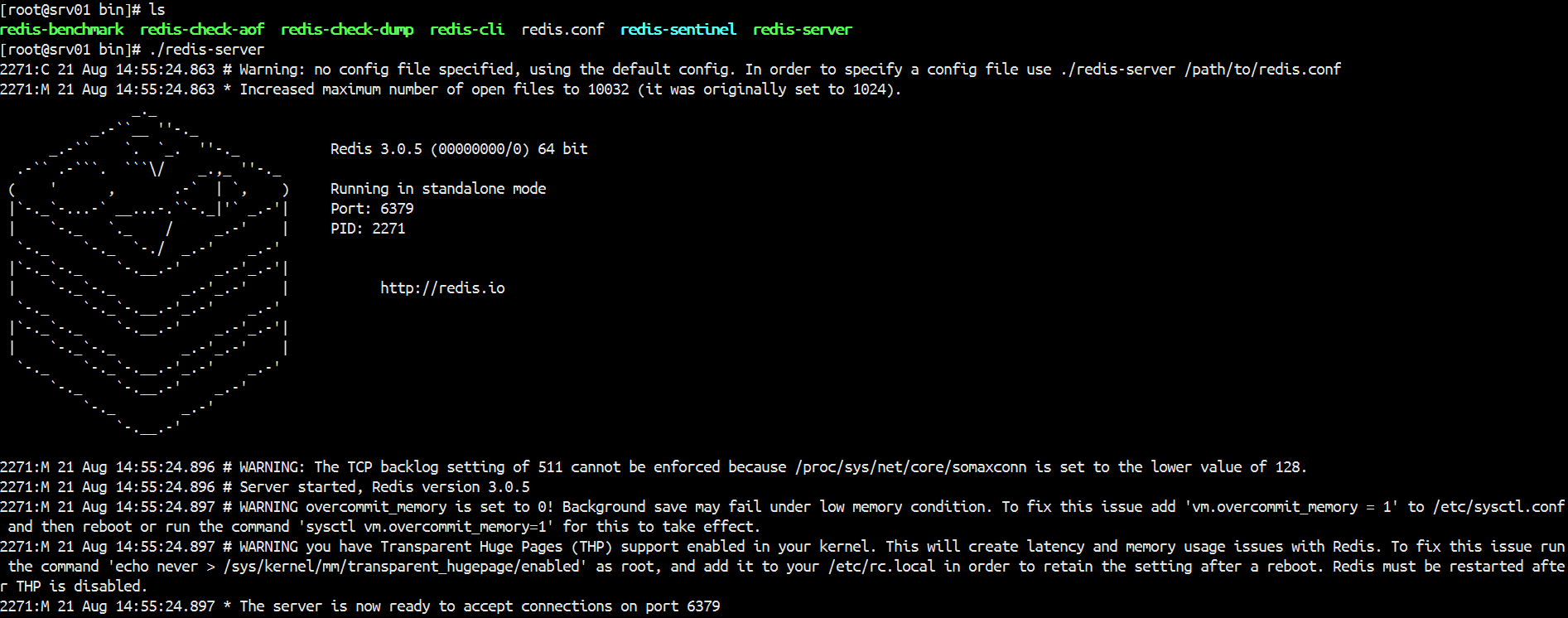

Redis- 内存数据库Redis之安装部署

内存数据库Redis之安装部署 Redis是一款非关系型,key-value存储的内存数据库,Redis数据库完全在内存中,使用磁盘仅用于持久性。Redis的速度非常快,每秒能执行约11万集合,每秒约81000+条记录。 支持丰富的数据类型:Redis支持字符串、列表、集合、有序集合散列数据类型,这使得它非常容易解决各种各样的问题。把redis看成java的一个hashmap你就入门…...

- 0

- 0

- 110

-

Spark- Linux下安装Spark

Spark- Linux下安装Spark 前期部署 1.JDK安装,配置PATH 可以参考之前配置hadoop等配置 2.下载spark-1.6.1-bin-hadoop2.6.tgz,并上传到服务器解压 [root@srv01 ~]# tar -xvzf spark-1.6.1-hadoop2.6.tgz /usr/spark-1.6.1-hadoop2.6 3.在 /usr 下…...

- 0

- 0

- 94

-

Spark- ERROR Shell: Failed to locate the winutils binary in the hadoop binary path java.io.IOException: Could not locate executable null\bin\winutils.exe in the Hadoop binaries.

报错 G:\APP\JDK\bin\java -Didea.launcher.port=7532 "-Didea.launcher.bin.path=G:\APP\IntelliJ IDEA\bin" -Dfile.encoding=UTF-8 -classpath "G:\APP\JDK\jre\lib\charsets.jar;G:\APP\JDK\…...

- 0

- 0

- 172

-

Spark- ERROR Shell: Failed to locate the winutils binary in the hadoop binary path java.io.IOException: Could not locate executable null\bin\winutils.exe in the Hadoop binaries.

运行 mport org.apache.log4j.{Level, Logger} import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} /** * Created by Lee_Rz on 2017/8/30. */ object SparkDemo { def main(args: A…...

- 0

- 0

- 143

-

Zeppelin- Linux下安装Zeppelin

前期部署: 下载,解压,配置PATH环境(编辑/etc/profile文件,记得source一下该文件) zepplin配置参考文档:https://zeppelin.apache.org/docs/0.7.2/install/configuration.html 往conf/zeppelin-env.sh文件中添加端口号 往底部添加 export ZEPPLELIN_PORT=8090 修改配置…...

- 0

- 0

- 106

-

Spark- Spark Yarn模式下跑yarn-client无法初始化SparkConext,Over usage of virtual memory

在spark yarn模式下跑yarn-client时出现无法初始化SparkContext错误. 17/09/27 16:17:54 INFO mapreduce.Job: Task Id : attempt_1428293579539_0001_m_000003_0, Status : FAILED Container [pid=7847,containerID=containe…...

- 0

- 0

- 85

-

Hadoop- Hadoop详解

首先所有知识以官网为准,所有的内容在官网上都有展示,所有的变动与改进,新增内容都以官网为准。hadoop.apache.org Hadoop是一个开源的可拓展的分布式并行处理计算平台,利用服务器集群根据用户的自定义业务逻辑,对海量数据进行分布式处理。Hadoop提供了一个可靠的共享存储和分析系统,Hadoop的核心三大组件有HDFS(分布式文件系统),MapReduce(分布式运算编程框架),YA…...

- 0

- 0

- 169

-

Hadoop- 分布式资源管理YARN架构讲解

YARN是分布式资源管理,每一台机器都要去管理该台计算机的资源,Yarn负责为MapReduce程序分配运算硬件资源。每一台机器的管理者叫 NodeManager,整个集群的管理者管理着整个集群的NodeManager,叫 ResourceManager。资源调度和资源隔离是YARN作为一个资源管理系统最重要和最基础的两个功能。资源调度由 ResourceManager 完成,而资源…...

- 0

- 0

- 99

-

Hadoop- HDFS的Safemode

Hadoop- HDFS的Safemode hadoop启动时,NameNode启动完后就开始进入安全模式,等待DataNode向NameNode发送block report ,当datanode blocks / total blocks = 99.99%,此时安全模式才会退出 安全模式下的操作: 可以查看文件系统的文件 在安全模式期间我们有些操作是不能进行的,比如不能改变文件系统…...

- 0

- 0

- 109

-

Hadoop- MapReduce在实际应用中常见的调优

1、Reduce Task Number 通常来说一个block就对应一个map任务进行处理,reduce任务如果人工不去设置干预的话就一个reduce。reduce任务的个数可以通过在程序中设置 job.setNumReduceTasks(个数); ,也可在配置文件上设置reduce任务个数,默认为1, 或者在代码config中配置 Configuration configura…...

- 0

- 0

- 84

-

Hadoop- 集群时间同步

集群的时间要同步 * 找一台机器 时间服务器 * 所有的机器与这台机器时间进行定时的同步 比如,每日十分钟,同步一次时间 # rpm -qa|grep ntp # vi /etc/ntp.conf # vi /etc/sysconfig/ntpd # Drop root to id 'ntp:ntp' by default. SYNC_HWCLOCK=yes OP…...

- 0

- 0

- 67

-

Hadoop- DistCp(分布式拷贝)

在实际的生产环境中,我们的企业都有测试集群和生产集群,有的比较大型的企业有多个版本的Hadoop 大数据集群,这时候有个这样的需求,各个集群上的资源需要进行迁移,比如说一些生产集群需要一些测试集群的数据,需要将测试集群的上的数据拷贝到生产集群,这时候就需要使用到分布式拷贝(Distributed Copy). 比较常见的有不同集群之间的数据迁移 hadoop distcp <s…...

- 0

- 0

- 104

-

Hive- 大数据仓库Hive

什么是 Hive? Hive 是由 FaceBook 开源用于解决少量数据结构化日志的数据统计。Hive是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射成一张表,并提供类SQL查询功能。Hive 处理的数据存储在 HDFS 上,分析数据的底层实现是 MapReduce ,执行程序运行的是YARN。 构建在Hadoop之上的数据仓库: 使用 HQL 作为查询接口 使…...

- 0

- 0

- 66

-

Hive- Hive 的基本操作

创建数据库 create database db_hive; use db_hive; create database if not exists db_hive_02; create database if not exists db_hive_01 location '/user/rz_lee/warehouse/db_hive_01.db'; //指定数据库…...

- 0

- 0

- 105

-

Spark- Spark基本工作原理

Spark特点: 1.分布式 spark读取数据时是把数据分布式存储到各个节点内存中 2.主要基于内存(少数情况基于磁盘,如shuffle阶段) 所有计算操作,都是针对多个节点上内存的数据,进行并行操作的 3.迭代式计算 对分布式节点内存中的数据进行处理,处理后的数据可能会移动到其他节点的内存中,当需要用到某些数据时,从这些节点的内存中就能找到,迭代出来使用 Spark与MapRed…...

- 0

- 0

- 97