-

Spark开发的大数据流水线系统:PiFlow v0.7

PiFlow是一个基于分布式计算框架Spark开发的大数据流水线系统。该系统将数据的采集、清洗、计算、存储等各个环节封装成组件,以所见即所得方式进行流水线配置。简单易用,功能强大。本次版本更新如下特性: 支持流水线组调度功能 支持数据源注册功能 支持流水线路由功能 优化流水线配置插件,支持标签、右键运行、更换图标、更换线型 优化监控页面 优化数据处理组件 优化启动配置项 下载地址: Gitee地址…...

- 0

- 0

- 153

-

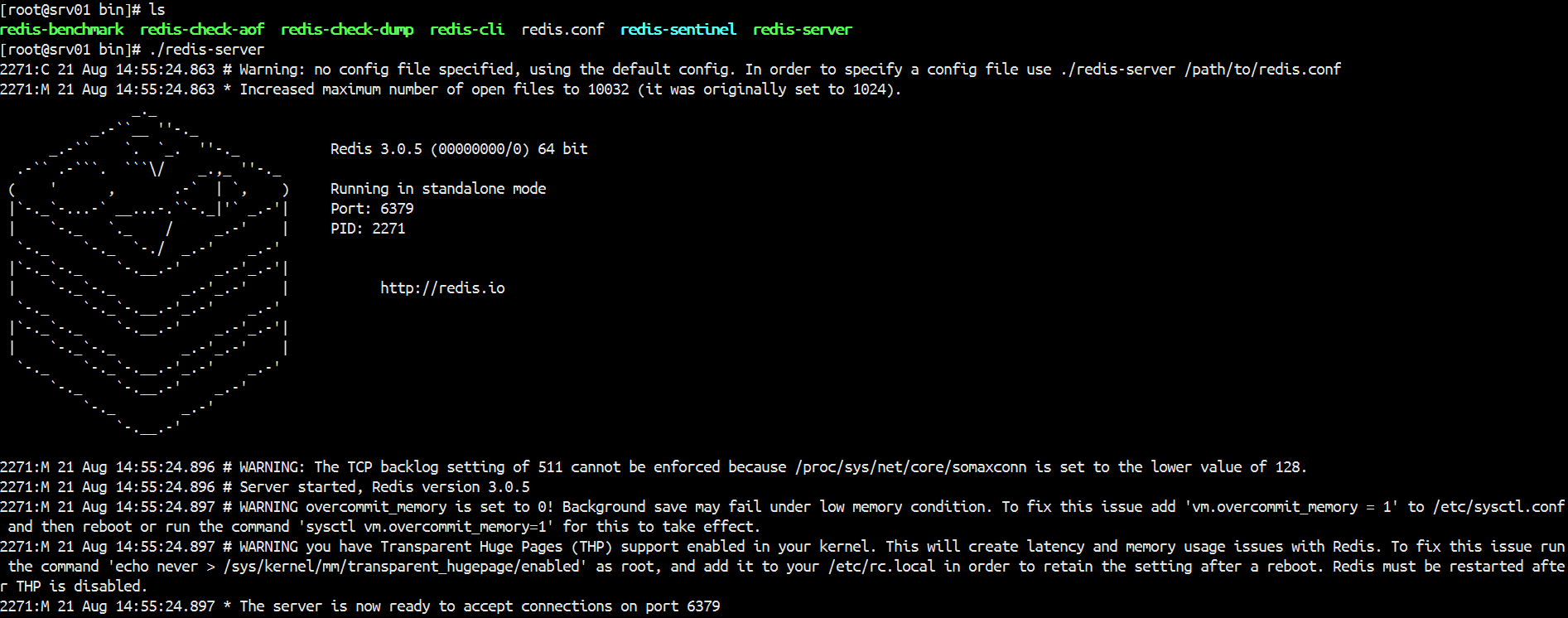

Redis- 内存数据库Redis之安装部署

内存数据库Redis之安装部署 Redis是一款非关系型,key-value存储的内存数据库,Redis数据库完全在内存中,使用磁盘仅用于持久性。Redis的速度非常快,每秒能执行约11万集合,每秒约81000+条记录。 支持丰富的数据类型:Redis支持字符串、列表、集合、有序集合散列数据类型,这使得它非常容易解决各种各样的问题。把redis看成java的一个hashmap你就入门…...

- 0

- 0

- 110

-

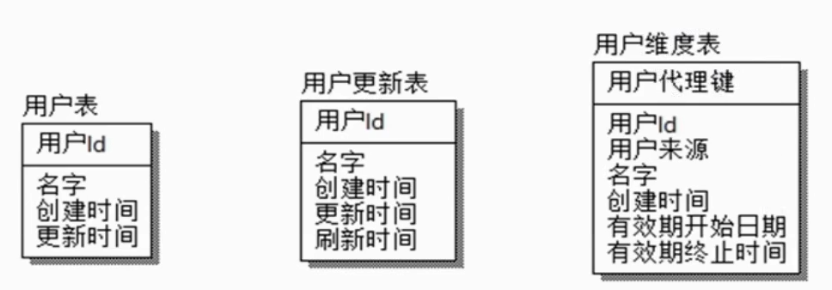

HIVE- SCD缓慢变化维

SCD缓慢变化维,比如一个用户维表,用户属性会变化,但是不会变化很剧烈,可能一年只会变化一两次,也不会所有用户的属性都会有变化,只有少量的数据发生变化,所以叫缓慢变化维。这种问题就是由于维度的变化所造成的。 解决方式: 是否保留历史数据 保留多久历史数据 历史状态如何与事实表关联 SCD1 保留最新状态 注册日期 用户编号 手机号码 2019-01-01 0001 111111 20…...

- 0

- 0

- 73

-

Apache Kudu 1.10.0 发布,Hadoop 生态数据存储系统

Apache Kudu 1.10.0 发布了,Kudu 是一个支持结构化数据的开源存储引擎,具有低延迟随机读取与高效分析读取模式。它基于 Apache Hadoop 生态系设计,并支持与 Apache 软件基金会其它数据分析项目集成。 此版本带来的新特性包括: Kudu 现在通过使用 Apache Spark 实现的作业支持完整和增量表备份。此外,它还支持通过使用 Apache Spark 实现的…...

- 0

- 0

- 132

-

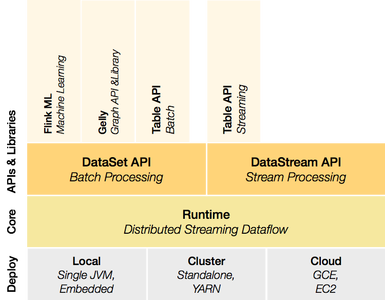

流处理框架:Apache Flink 1.9.3

Apache Flink 是高效和分布式的通用数据处理平台。 Apache Flink 声明式的数据分析开源系统,结合了分布式 MapReduce 类平台的高效,灵活的编程和扩展性。同时在并行数据库发现查询优化方案。 要求 Unix 类环境(Linux, Mac OS X, Cygwin) git Maven (at least version 3.0.4) Java 6, 7 or 8 (Not…...

- 0

- 0

- 71

-

Hive- Hive安装

Hive安装 1.1下载Hive安装包 官网:http://hive.apache.org/downloads.html 个人建议到这里下载:http://apache.forsale.plus/ 1.2将hive文件上传到HADOOP集群,并解压 将文件上传到 /usr ,解压 tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /usr/ 重命名:…...

- 0

- 0

- 83

-

Python 爬虫框架Scrapy 2.0.0

Scrapy 是一套基于 Twisted 的异步处理框架,纯 Python 实现的爬虫框架,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各种图片。 此版本主要更新亮点包括: 不再支持 Python 2 部分协程语法支持和实验性异步支持 新的 Response.follow_all 方法 FTP 对媒体管道的支持 新的 Response.certificate 属性 通过…...

- 0

- 0

- 123

-

Spark- 流量日志分析

日志生成 package zx.Utils import java.io.{File, FileWriter} import java.util.Calendar import org.apache.commons.lang.time.{DateUtils, FastDateFormat} import scala.collection.mutable.ArrayBuffer imp…...

- 0

- 0

- 91

-

ERROR- 开发常见error

一,数据插入MySql中出现中文乱码 解决办法有: 1。新建数据库选择 create database 'GG' CHARACTER SET 'utf8 ' COLLATE 'utf8_general_ci '; 2。建表的时候: CREATE TABLE `TableA` (`ID` varchar(40) NOT NUL…...

- 0

- 0

- 72

-

Spark- 常见问题

记录spark使用中常见问题 SparkSQL 日期解析时用到SimpleDateFormat, SimpleDateFormat是线程不安全的。可以使用 FastDateFormat 如: import org.apache.commons.lang3.time.FastDateFormat // 输入文件日期时间格式 // [10/Nov/2018:00:01:02 +0800]…...

- 0

- 0

- 87

-

世界上使用量最大的数据库引擎SQLite 3.31.0

SQLite 是一个 C 实现的 SQL 数据库引擎,它的特点是小型、快速、自包含、高可靠性和功能齐全。SQLite 嵌入在所有手机和大多数计算机中,也捆绑在为数众多的其它应用中,是世界上使用量最大的数据库引擎。作为 2020 年的第一个大版本,SQLite 3.31.0 已完成发布,该版本主要功能之一是对生成/计算列的支持。具体更新内容如下: 添加对生成列的支持。 添加 sqlite3_har…...

- 0

- 0

- 78

-

Spark- Linux下安装Spark

Spark- Linux下安装Spark 前期部署 1.JDK安装,配置PATH 可以参考之前配置hadoop等配置 2.下载spark-1.6.1-bin-hadoop2.6.tgz,并上传到服务器解压 [root@srv01 ~]# tar -xvzf spark-1.6.1-hadoop2.6.tgz /usr/spark-1.6.1-hadoop2.6 3.在 /usr 下…...

- 0

- 0

- 94

-

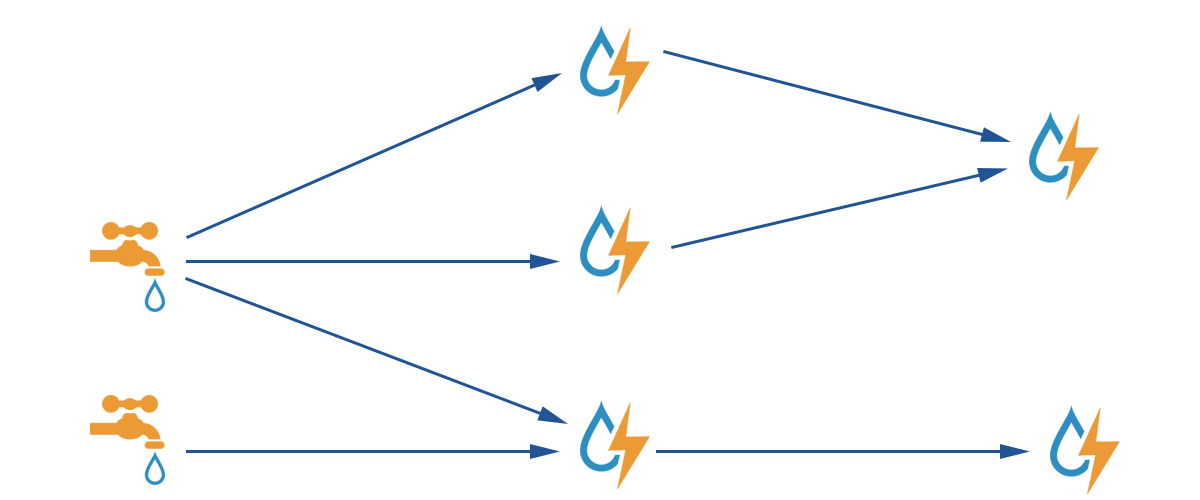

Spark- 优化后的 shuffle 操作原理剖析

在spark新版本中,引入了 consolidation 机制,也就是说提出了ShuffleGroup的概念。一个 ShuffleMapTask 将数据写入 ResultTask 数量的本地文本,这个不会变。但是,当下一个 ShuffleMapTask 运行的时候,可以直接将数据写入之前的 ShuffleMapTask 的本地文件。相当于是,对多个 ShuffleMapTask 输出…...

- 0

- 0

- 54

-

HIVE- 新建UDF范例

首先pom文件导入依赖,Hadoop和hive的依赖导入自己机器的版本,hive记得导jdbc <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>2.6.1</v…...

- 0

- 0

- 75

-

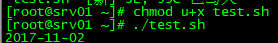

Hive- Hive 按时间定期插入分区表

写个shell脚本Hive 按时间定期插入分区表,由于今天统计的是昨天的数据所以日期减一。 #!/bin/bash DT=`date -d '-1 day' "+%Y-%m-%d"` #如果某天的数据有误需要重跑 if [ $1 ];then DT=$1 fi SQL=" insert overwrite table t…...

- 0

- 0

- 65

-

Spark- RDD简介

Spark里面提供了一个比较重要的抽象——弹性分布式数据集(resilient distributed dataset),简称RDD。弹性:数据可大可小,可分布在内存或磁盘,当某台机器宕机时,能够按照RDD的liveage重新计算,从而恢复。 RDD有5个特性: 1.一个分区列表,用于并行计算,每个分区对应一个原子数据集,作为这个分区的数据输入 2.计算这个RDD某个分区数据(这个分…...

- 0

- 0

- 77

-

Python- NumPy

NumPy包括的内容 NumPy系统是 Python的一种开源的数值计算扩展,是一个用 python实现的科学计算包。包括: 一个具有矢量算术运算和复杂广播能力的快速且节省空间的多维数组,称为 ndarray(N-dimensional array object ) 用于对整组数据进行快速运算的标准数学函数, func( universal function object) 用于整…...

- 0

- 0

- 187

-

Kafka- Kafka架构功能

Kafka是一个高吞吐量的分布式消息系统,一个分布式的发布-订阅消息系统。Kafka是一种快速,可拓展的,设计内在就是分布式的,分区的可复制的提交日志服务。 Apache Kafka与传统消息系统相比,有以下不同: 它设计为一个分布式系统,易于向外拓展; 它同时为发布和订阅提供高吞吐量; 它支持多订阅者,当失败时能自动平衡消费者; 它将消息持久化到磁盘,因此可用于批量消费,例如ETL…...

- 0

- 0

- 53

-

Hive- 大数据仓库Hive

什么是 Hive? Hive 是由 FaceBook 开源用于解决少量数据结构化日志的数据统计。Hive是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射成一张表,并提供类SQL查询功能。Hive 处理的数据存储在 HDFS 上,分析数据的底层实现是 MapReduce ,执行程序运行的是YARN。 构建在Hadoop之上的数据仓库: 使用 HQL 作为查询接口 使…...

- 0

- 0

- 66

-

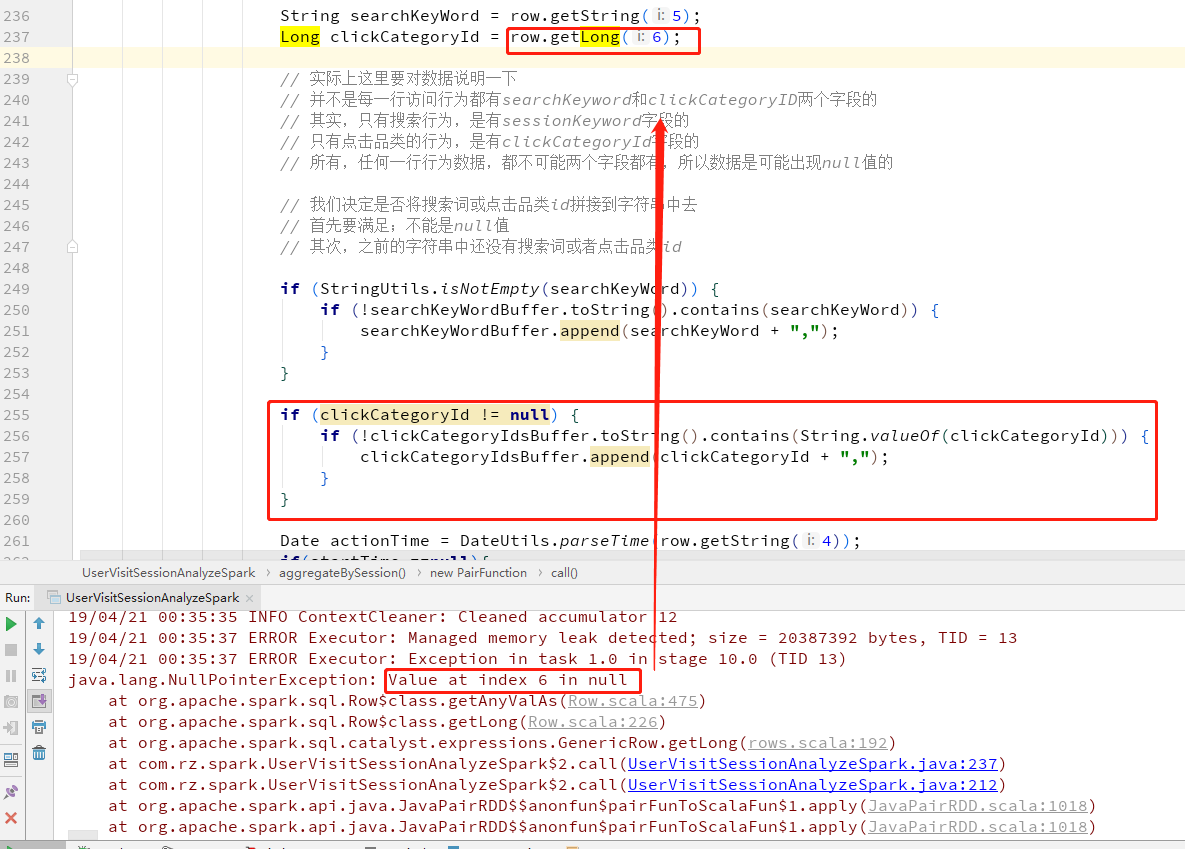

Spark- SparkSQL中 Row.getLong 出现NullPointerException错误的处理方法

在SparkSQL中获取Row的值,而且Row的字段允许null时,在取值的时候取到null赋值给新的变量名会报NullPointerException错误, 可以先用row.isNullAt(index)去判断该字段的值是否为空 首先上错误 修改为先初始化变量,判断row.isNullAt(6) 如果不为空就将值赋值给变量 ...

- 0

- 0

- 117

-

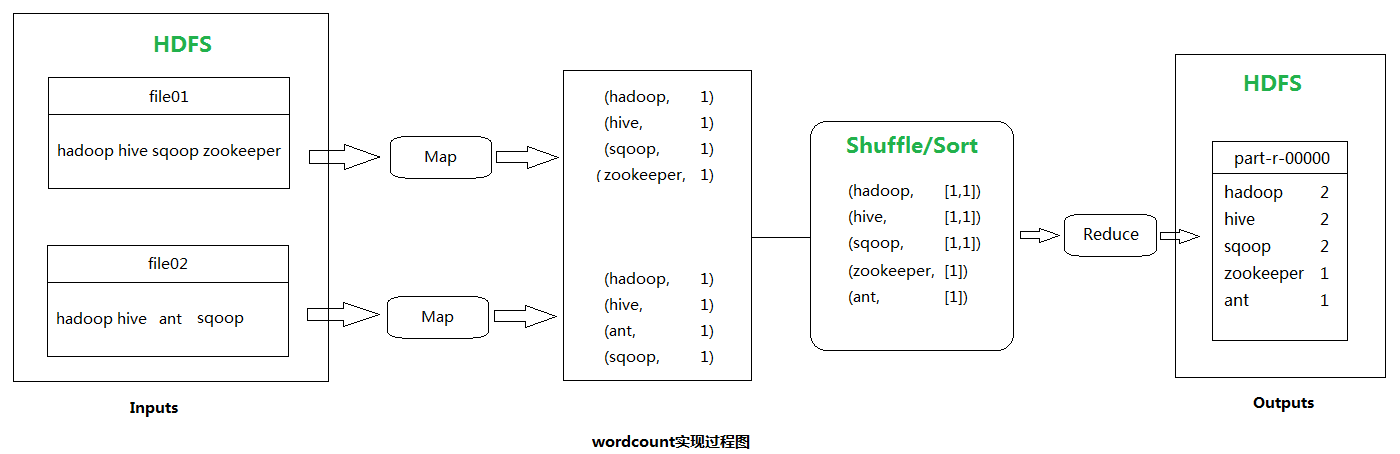

Hadoop- Wordcount程序原理及代码实现

如果对Hadoop- MapReduce分布式计算框架原理还不熟悉的可以先了解一下它,因为本文的wordcount程序实现就是MapReduce分而治之最经典的一个范例。 单词计数(wordcount)主要步骤: 1.读数据 2.按行处理 3.按空格切分行内单词 4.HashMap(单词,value+1) 等分给自己的数据片全部读取完之后 5.将HashMap按照首字母范围分为3个H…...

- 0

- 0

- 94

-

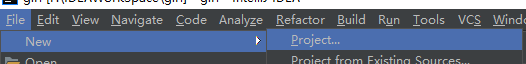

Spring Boot- 用idea新建spring boot web项目

1.新建project 2.选择Spring Initializr,next 3.输入项目信息,next 4.选择web依赖以及Spring Boot的版本,next 5.Finish 6.Enable Auto-Import ...

- 0

- 0

- 67

-

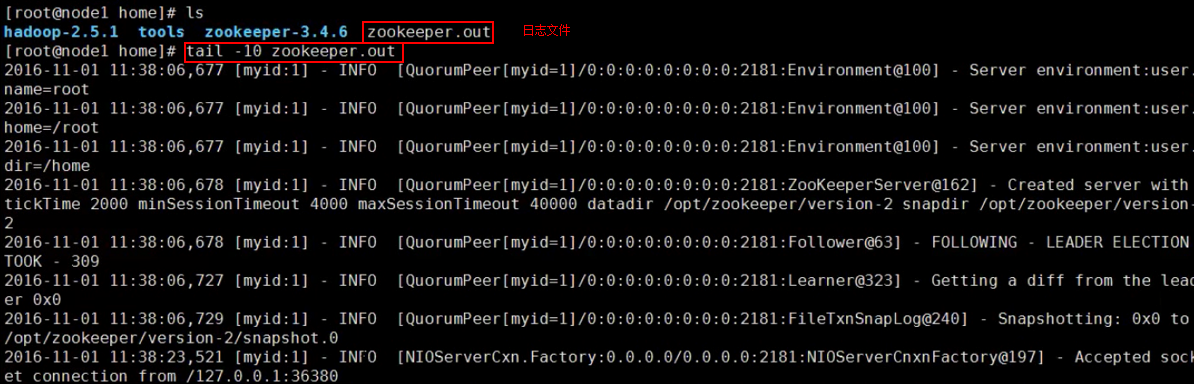

Hadoop HA- hadoop集群部署

前期部署,至少准备3台服务器(可以是虚拟机) 1、linux系统环境准备 ip地址配置 hostname配置 hosts映射配置 关闭防火墙 service iptables stop ,也可以设置防火墙不开机自启动 chkconfig iptables off init启动级别修改 2.java环境的配置 上传jdk,解压,修改/etc/profile 3.zookeeper集群…...

- 0

- 0

- 118

-

Springboot- pagehelper使用

1.添加pagehelper依赖 <dependency> <groupId>org.github.pagehelper</groupId> <artifactId>pagehelper-spring-boot-starter</artifactId> <version>1.3.2</version>…...

- 0

- 0

- 71

-

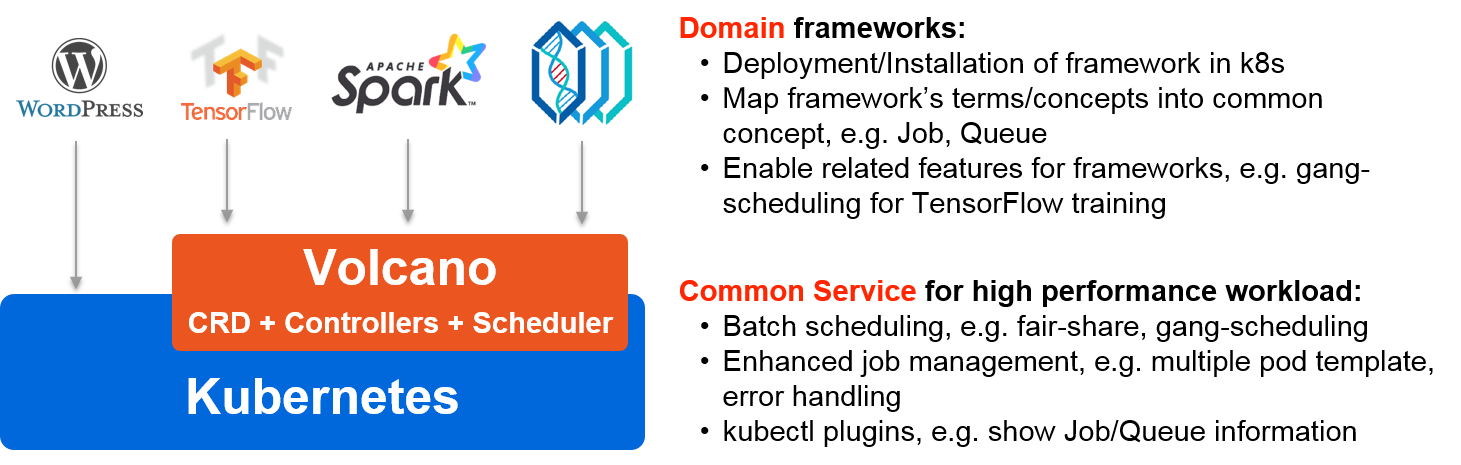

华为发布 Volcano 开源项目,方便 AI、大数据、基因、渲染等诸多行业通用计算框架接入

Volcano 是基于 Kubernetes 的批处理系统,源自于华为云 AI 容器。Volcano 方便 AI、大数据、基因、渲染等诸多行业通用计算框架接入,提供高性能任务调度引擎,高性能异构芯片管理,高性能任务运行管理等能力。 授权协议: Apache 开发语言: Google Go 操作系统: Linux 开发厂商: 华为 整体架构 Volcano 提供一整套目前 K8S 在批量和弹性工作负…...

- 0

- 0

- 251

-

基于 Python 的开源量化交易平台开发框架 VN.PY 2.1.2

vn.py - 基于 Python 的开源交易平台开发框架 vn.py 项目起源于国内私募的自主交易系统,2015 年初启动时只是单纯的交易 API 接口的 Python 封装。随着业内关注度的上升和社区不断的贡献,目前已经一步步成长为一套全面的交易程序开发框架,用户群体也日渐多样化,包括私募基金、证券自营和资管、期货资管和子公司、高校研究机构、个人投资者等。 丰富的 Python 交易和数据 A…...

- 0

- 0

- 191

-

Hadoop- HDFS的API操作

1、引入依赖 <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>2.6.1</version> </dependency> 注:如需手动引入ja…...

- 0

- 0

- 150

-

Hive- Hive 的基本操作

创建数据库 create database db_hive; use db_hive; create database if not exists db_hive_02; create database if not exists db_hive_01 location '/user/rz_lee/warehouse/db_hive_01.db'; //指定数据库…...

- 0

- 0

- 104

-

Hadoop- NameNode和Secondary NameNode元数据管理机制

元数据的存储机制A、内存中有一份完整的元数据(内存meta data)B、磁盘有一个“准完整”的元数据镜像(fsimage)文件(在namenode的工作目录中)C、用于衔接内存metadata和持久化元数据镜像fsimage之间的操作日志(edits文件)NameNode和Secondary NameNode元数据管理机制客户端每次对文件的操作,如果涉及到元数据的更新(读除外),比如…...

- 0

- 0

- 74

-

Hadoop- DistCp(分布式拷贝)

在实际的生产环境中,我们的企业都有测试集群和生产集群,有的比较大型的企业有多个版本的Hadoop 大数据集群,这时候有个这样的需求,各个集群上的资源需要进行迁移,比如说一些生产集群需要一些测试集群的数据,需要将测试集群的上的数据拷贝到生产集群,这时候就需要使用到分布式拷贝(Distributed Copy). 比较常见的有不同集群之间的数据迁移 hadoop distcp <s…...

- 0

- 0

- 102

-

Kafka- Spark消费Kafka

在高版本的API中 val brokers = properties.getProperty("kafka.host.list") val topics = Set(properties.getProperty("kafka.application.topic")) val kafkaParams = Map[String, String]( …...

- 0

- 0

- 95

-

Spark- 计算每个学科最受欢迎的老师

日志类型 测试数据 http://bigdata.myit.com/zhangsan http://bigdata.myit.com/zhangsan http://bigdata.myit.com/zhangsan http://bigdata.myit.com/zhangsan http://bigdata.myit.com/zhangsan http://java.myit.c…...

- 0

- 0

- 103

-

SpringBoot- springboot集成Redis出现报错:No qualifying bean of type ‘org.springframework.data.redis.connection.RedisConnectionFactory’

Springboot将accessToke写入Redisk 缓存,springboot集成Redis出现报错 No qualifying bean of type 'org.springframework.data.redis.connection.RedisConnectionFactory' 原因:我们在pom.xml中引入了spring-boo…...

- 0

- 0

- 417

-

Spark- 根据ip地址计算归属地

主要考察的是广播变量的使用: 1、将要广播的数据 IP 规则数据存放在HDFS上,(广播出去的内容一旦广播出去产就不能改变了,如果需要实时改变的规则,可以将规则放到Redis中) 2、在Spark中转成RDD,然后收集到Driver端, 3、把 IP 规则数据广播到Executor中。Driver端广播变量的引用是怎样跑到 Executor中的呢? Task在Driver端生成的,…...

- 0

- 0

- 156

-

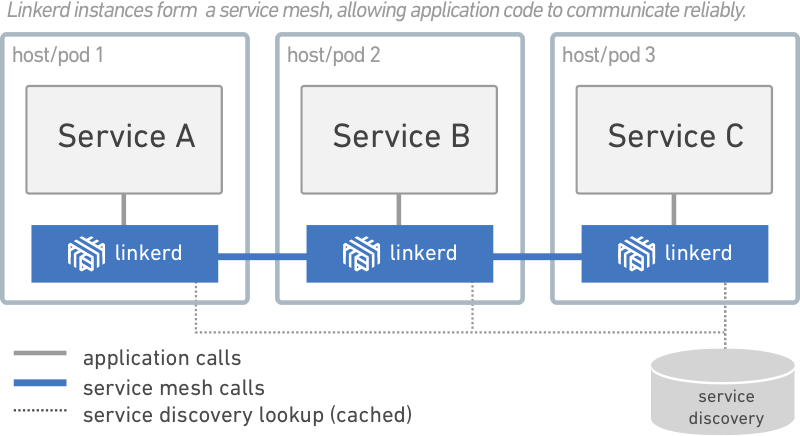

弹性云端原生应用服务网格:Linkerd 2.8

Linkerd 是一个提供弹性云端原生应用服务网格(service mesh)的开源项目,也是面向微服务的开源 RPC 代理。它的核心是一个透明代理。 linkerd(发音 "linker-DEE")是一个透明的服务网格,旨在通过透明地将服务发现、负载均衡、故障处理,插桩(instrumentation)和路由添加到所有的服务间通信中,使现代应用程序安全可靠,而无需侵入应用内部…...

- 0

- 0

- 119

-

Spark- 使用hiveContext时提交作业报错

在spark上操作hive时不需要搭建hive环境,只需要从现有的hive集群中hive的conf目录下拷贝 hive-site.xml 到spark的conf目录下即可提交程序运行 出现报错 Caused by: org.datanucleus.exceptions.NucleusException: Attempt to invoke the "BONEC…...

- 0

- 0

- 62

-

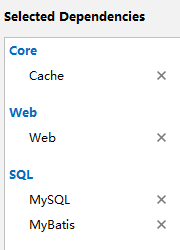

Springboot- Spring缓存抽象学习笔记

Spring缓存作用准备: 1、准备数据(准备一个有数据的库和表/导入数据库文件,准备好表和表里面的数据) 2、创建javaBean封装数据 3、整合MyBatis操作数据库( 这里用MyBatis) 1,配置数据源信息 2、使用注解版的MyBatis; 1)、@MapperScan指定需要扫描的Mapper接口所在的包 创建一个springboot项目 -》选择依赖(…...

- 0

- 0

- 123

-

Hadoop- Hadoop详解

首先所有知识以官网为准,所有的内容在官网上都有展示,所有的变动与改进,新增内容都以官网为准。hadoop.apache.org Hadoop是一个开源的可拓展的分布式并行处理计算平台,利用服务器集群根据用户的自定义业务逻辑,对海量数据进行分布式处理。Hadoop提供了一个可靠的共享存储和分析系统,Hadoop的核心三大组件有HDFS(分布式文件系统),MapReduce(分布式运算编程框架),YA…...

- 0

- 0

- 168

-

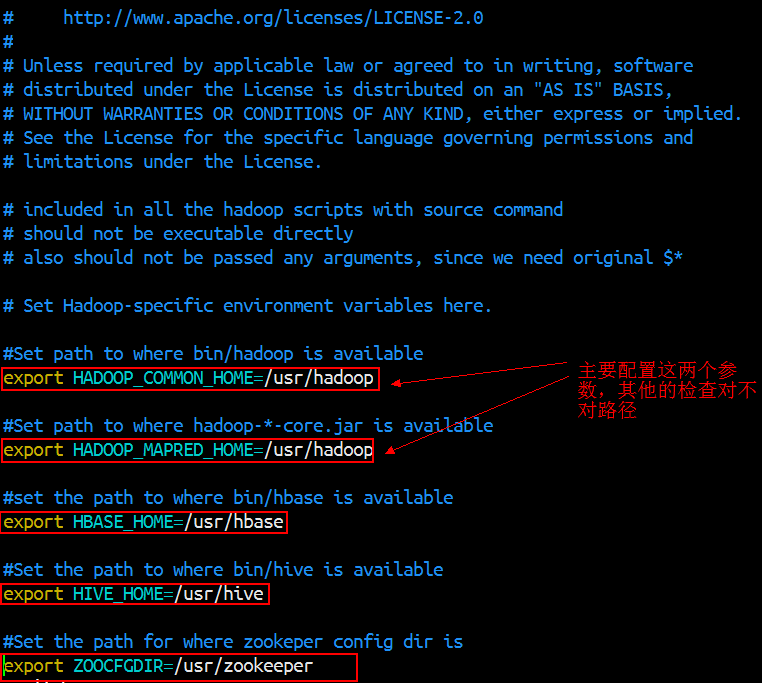

Sqooop- 使用Sqoop进行数据的导入导出

Sqoop是Apache旗下的一个开源框架,专门用来做数据的导入和导出。 官网:https://sqoop.apache.org/ Sqoop的安装非常简单,只需要把下载下来的tar包解压设置两个环境变量就可以了 1.安装部署 下载版本:sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz 官网:http://mirror.bit.edu.cn/apa…...

- 0

- 0

- 162

-

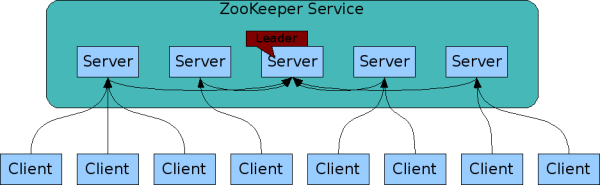

分布式服务框架:Apache ZooKeeper 3.6.1

ZooKeeper是Hadoop的正式子项目,它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、分布式同步、组服务等。ZooKeeper的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效、功能稳定的系统提供给用户。 Zookeeper是Google的Chubby一个开源的实现.是高有效和可靠的协同工作系统.Zookeeper能够用来leader选举,配置信…...

- 0

- 0

- 138

-

分布式实时计算:Apache Storm 2.2.0

Apache Storm 2.2.0更新内容如下: 新特性 将 backtype.storm.messaging.netty-integration-test 端口移植到 Java 将 backtype.storm.submitter-test 端口移植到 Java NUMA 支持 HB 超时可在拓扑级别配置 每个 Worker RAS 选项实施一个执行程序 添加配置以将调度程序行为列入黑名单 更…...

- 0

- 0

- 92

-

Spark- Spark普通Shuffle操作的原理剖析

在spark中,什么情况下会发生shuffle? reduceByKey,groupByKey,sortByKey,countByKey,join,cogroup等操作。 默认的shuffle操作的原理剖析 假设有一个节点上面运行了4个 ShuffleMapTask,然后这个节点上只有2个 cpu core。假如有另外一台节点,上面也运行了4个ResultTask,现在呢,正等着要去…...

- 0

- 0

- 58

-

Spark- JdbcRDD以及注意事项

先上Demo package com.rz.spark.base import java.sql.DriverManager import org.apache.spark.rdd.JdbcRDD import org.apache.spark.{SparkConf, SparkContext} object JdbcRDDDemo { def main(args: Array[St…...

- 0

- 0

- 57

-

CDH- cdh kafka已经卸载了,但是服务器还有kafka-topics这些命令可用,导致重新安装kafka出现问题

CDH- cdh kafka已经卸载了,但是服务器还有kafka-topics这些命令可用,导致重新安装kafka出现问题 cdh界面删除并不会将 kafka数据删除,需要将kafka集群节点 var/local/kafka/data 清理掉 然后将zk brokers/topics 下的topic也清理掉 ...

- 0

- 0

- 59

-

Spark- Spark Yarn模式下跑yarn-client无法初始化SparkConext,Over usage of virtual memory

在spark yarn模式下跑yarn-client时出现无法初始化SparkContext错误. 17/09/27 16:17:54 INFO mapreduce.Job: Task Id : attempt_1428293579539_0001_m_000003_0, Status : FAILED Container [pid=7847,containerID=containe…...

- 0

- 0

- 85

-

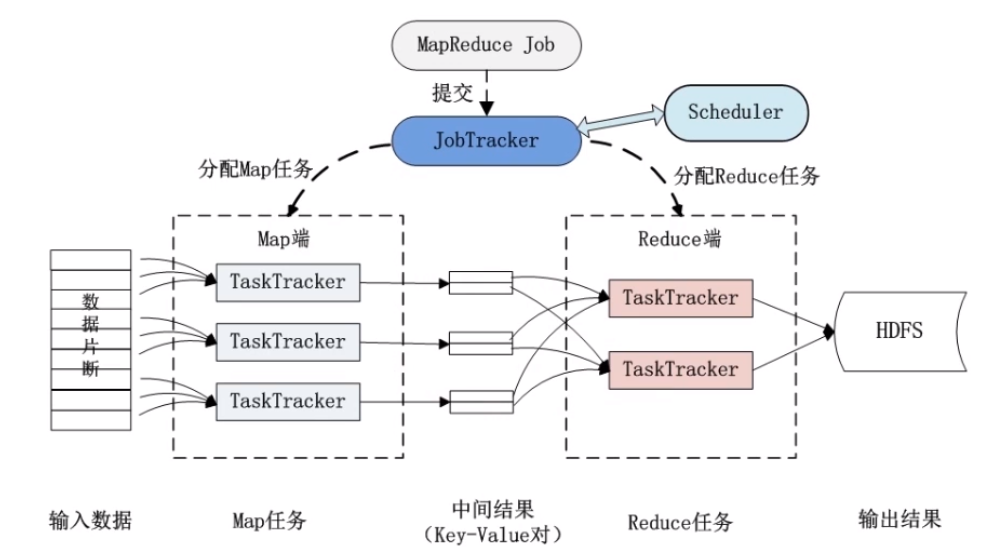

Hadoop- MapReduce分布式计算框架原理

分布式计算:原则:移动计算而尽可能减少移动数据(减少网络开销)分布式计算其实就是将单台机器上的计算拓展到多台机器上并行计算。 MapReduce是一种编程模型。Hadoop MapReduce采用Master/slave 结构。只要按照其编程规范,只需要编写少量的业务逻辑代码即可实现一个强大的海量数据并发处理程序。核心思想是:分而治之。Mapper负责分,把一个复杂的业务,任…...

- 0

- 0

- 109

-

Spark- 数据清洗

输入输出转化工具类 package com.rz.mobile_tag.log import org.apache.spark.sql.Row import org.apache.spark.sql.types.{LongType, StringType, StructField, StructType} /** * 访问日志转换(输入==>输出)工具类 */ object A…...

- 0

- 0

- 109

-

Python- 列表内置方法

列表,元组 查 索引(下标) ,都是从0开始 切片 .count 查某个元素的出现次数 .index 根据内容找其对应的位置 "haidilao ge" in a 增加 a.append() 追加 a.insert(index, "内容") a.extend 扩展 修改 a[index] = "新的值" a[start:en…...

- 0

- 0

- 118

-

Spark- 性能优化

由于Spark 的计算本质是基于内存的,所以Spark的性能城西的性能可能因为集群中的任何因素出现瓶颈:CPU、网络带宽、或者是内存。如果内存能够容得下所有的数据,那么网络传输和通信就会导致性能出现频惊。但是如果内存比较紧张,不足以放下所有的数据(比如在针对10亿以上的数据量进行计算时),还是需要对内存的使用进行性能优化的,比如说使用一些手段来减少内存的消耗。 Spark性能优化,其…...

- 0

- 0

- 86

-

数据仓库- 建模理念

数仓建模的目标 访问性能:能够快速查询所需的数据,减少数据I/O 数据成本:减少不必要的数据冗余,实现计算结果数据复用,降低大数据系统中的存储成本和计算成本。 使用效率:改善用户使用体验,提高使用数据的效率 数据质量:改善数据统计口径的不一致性,减少数据计算错误的可性,提供高质量的、一致的数据访问平台 大数据的数仓建模需要通过建模的方法更好的组织、存储数据、以便在性能、…...

- 0

- 0

- 67