-

Linux安装Scala(小白版)

一、下载Scala安装包 从scala官方网站地址:http://www.scala-lang.org/download/下载scala二进制包,以2.12.6版本为例 二、安装 1、将下载的二进制包移动到/usr/local目录,解压缩文件包 tar zxvf scala-2.12.6.tgz mv scala-2.12.6 scala //重命名目录 2、设置环境变量 vi /etc/pro…- 0

- 1

- 69

-

-

Linux- 恢复.swp文件

当我们对Linux文件系统下的文件编辑时,很多新手老手都有可能出现一些失误,在对一个文件编辑或者改动,甚至是不小心按到键盘并没有发现改动到某处时,没有强制退出(:q!)就直接退出,导致文件变成了.swp后缀并隐藏起来。在对源文件编辑时提示你只读,还原,退出等等。 输入 ls -a或 ll -a 可以看到刚刚在编辑的文件变成了隐藏文件。 这时候想要恢复回原来的文件如何处理呢。不能通过直…- 0

- 0

- 84

-

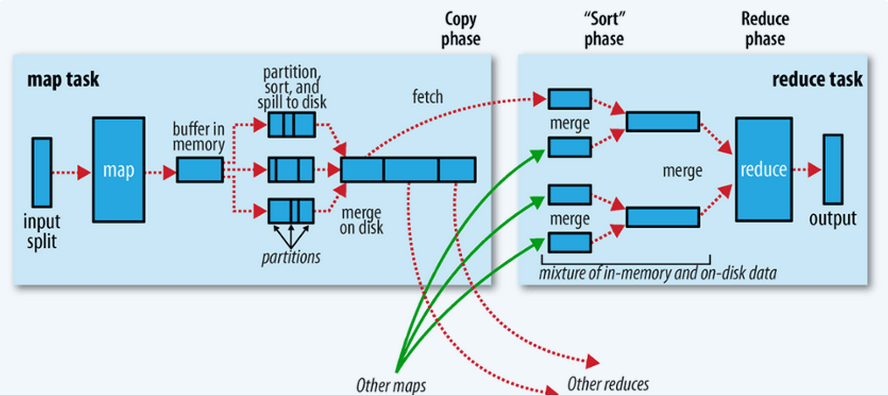

Hadoop- MR的shuffle过程

step1 input InputFormat读取数据,将数据转换成<key ,value>对,设置FileInputFormat,默认是文本格式(TextInputFormat) step2 map map<KEYIN, VALUEIN, KEYOUT, VALUEOUT> 默认情况下KEYIN:LongWritable,偏移量。VALUEIN:Text,K…- 0

- 0

- 63

-

Spring- 异常org.xml.sax.SAXParseException; systemId: http://www.springframework.org/schema/context/; lineNumber: 1; columnNumber: 55; 在 publicId 和 systemId 之间需要有空格。

抛出异常 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 六月 03, 2018 7:40:44 下午 org…- 0

- 0

- 122

-

Spark- 根据ip地址计算归属地

主要考察的是广播变量的使用: 1、将要广播的数据 IP 规则数据存放在HDFS上,(广播出去的内容一旦广播出去产就不能改变了,如果需要实时改变的规则,可以将规则放到Redis中) 2、在Spark中转成RDD,然后收集到Driver端, 3、把 IP 规则数据广播到Executor中。Driver端广播变量的引用是怎样跑到 Executor中的呢? Task在Driver端生成的,…- 0

- 0

- 156

-

应用层各协议用的端口

在TCP/IP体系中应用层各协议用的端口 端口号 协议 协议名称 20 FTP-DATA 文件传输协议数据 21 FTP 文件传输协议控制 23 TELENET 远程登录协议 25 SMPT 简单邮件传输协议 53 DOMAIN 域名服务器 80 HTTP 超文本传输协议 110 POP3 邮局协议 119 NNTP 新闻传输协议 67,68 BOOTP 引导程序协议 基于TC…- 0

- 0

- 56

-

JAVA- 面向对象

程序的发展经历了两个主要阶段:面向过程、面向对象。面向对象是当前软件开发的主流。 面向过程就是分析出解决所需要的步骤,然后用函数将这些步骤一步一步实现,使用的时候一个一个一次调用。 面向对象是把构成问题的事务分解成各个对象。建立对象的目的不是为了完成一个步骤而是为了描述某个事物在整个解决问题步骤中的行为。 面向对象是为了专注在程序中采用封装、继承、多态等设计方法。面向对象的设计是一种…- 0

- 0

- 87

-

Spark- ERROR Shell: Failed to locate the winutils binary in the hadoop binary path java.io.IOException: Could not locate executable null\bin\winutils.exe in the Hadoop binaries.

运行 mport org.apache.log4j.{Level, Logger} import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} /** * Created by Lee_Rz on 2017/8/30. */ object SparkDemo { def main(args: A…- 0

- 0

- 143

-

-

Storm- 使用Storm实现词频汇总

需求:读取指定目录的数据,并实现单词计数的功能 实现方案: Spout来读取指定目录的数据,作为后续Bolt处理的input 使用一个Bolt把input 的数据,切割分开,我们按照逗号进分割 使用一个Bolt来进行最终的单词次数统计操作并输出 拓扑设计:DataSourceSpout ==>SpiltBolt ==>CountBolt Storm编程注意,…- 0

- 0

- 86

-

spark- PySparkSQL之PySpark解析Json集合数据

PySparkSQL之PySpark解析Json集合数据 数据样本 12341234123412342|asefr-3423|[{"name":"spark","score":"65"},{"name":"airlow","score":&quo…- 0

- 0

- 81

-

Hive- Hive 的基本操作

创建数据库 create database db_hive; use db_hive; create database if not exists db_hive_02; create database if not exists db_hive_01 location '/user/rz_lee/warehouse/db_hive_01.db'; //指定数据库…- 0

- 0

- 105

-

Hadoop- Namenode经常挂掉 IPC’s epoch 9 is less than the last promised epoch 10

如题出现Namenode经常挂掉 IPC's epoch 9 is less than the last promised epoch 10, 2019-01-03 05:36:14,774 INFO org.apache.hadoop.hdfs.StateChange: BLOCK* allocate blk_1073741949_1131{UCState=…- 0

- 0

- 217

-

单机版Spark安装及PySpark环境配置

单机版Spark安装 到官网http://archive.apache.org/dist/spark/ 下选择版本下载spark包,本次采用的是预编译版本 选择spark-1.6.1-bin-hadoop2.6.tgz 解压到/opt/目录下 tar -xvzf spark-1.6.1-bin-hadoop2.6.tgz -C /opt/ [root@hdp spark-1.6.1-bin-had…- 0

- 0

- 171

-

Linux学习之路(一)命令基本格式

据统计Linxu里面能够识别的命令超过3000个,而我们常用的Linux基本命令在60个左右。常用命令是我们必须掌握的命令,需要我们多练习才能记住,最起码要敲3遍以上。 简单的把常用命令分为以下几大类: Linux常用命令 一、命令基本格式 二、文件处理命令 三、文件搜索命令 四、帮助命令 五、压缩与解压缩命令 六、关机和重启命令 七、其他常用命令 一、命令基本格式 L…- 0

- 0

- 47

-

Hive- Hive安装

Hive安装 1.1下载Hive安装包 官网:http://hive.apache.org/downloads.html 个人建议到这里下载:http://apache.forsale.plus/ 1.2将hive文件上传到HADOOP集群,并解压 将文件上传到 /usr ,解压 tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /usr/ 重命名:…- 0

- 0

- 83

-

Hive- Hive 按时间定期插入分区表

写个shell脚本Hive 按时间定期插入分区表,由于今天统计的是昨天的数据所以日期减一。 #!/bin/bash DT=`date -d '-1 day' "+%Y-%m-%d"` #如果某天的数据有误需要重跑 if [ $1 ];then DT=$1 fi SQL=" insert overwrite table t…- 0

- 0

- 65

-

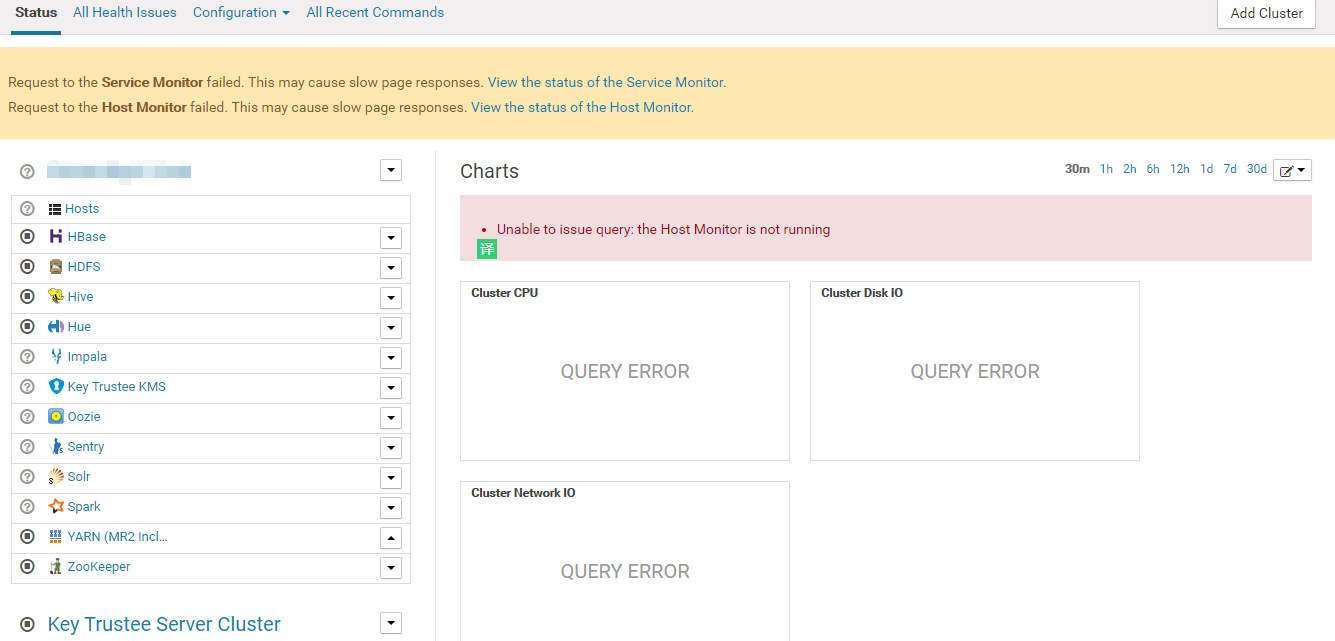

CDH- CDH大数据集群运维

CDH前端CM监控不正常(未解决) Request to the Service Monitor failed. This may cause slow page responses. View the status of the Service Monitor. Request to the Host Monitor failed. This may cause sl…- 0

- 0

- 237

-

Spark- 自定义排序

考察spark自定义排序 方式一:自定义一个类继承Ordered和序列化,Driver端将数据变成RDD,整理数据转成自定义类类型的RDD,使用本身排序即可。 package com.rz.spark.base import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} // 自定…- 0

- 0

- 103